全球領先的 AI 研究實驗室之一,Black Forest Labs,剛徹底顛覆了影像生成的遊戲規則

實驗室中 FLUX.1 影像模型因能提供高品質視覺效果和卓越的提示遵循度,而受到全球的關注。 如今,實驗室推出的全新 FLUX.1 Kontext 模型,徹底改變了使用者引導和完善影像生成流程的方式。

為了獲得理想效果,現今的 AI 藝術家通常會結合模型和 ControlNets — 即 AI 模型,協助引導影像生成器輸出。 通常需要結合多個 ControlNet,或採用先進技術,例如 用於 3D 引導式影像生成的 NVIDIA AI Blueprint,也就是使用草圖 3D 場景來確定影像的構圖。

全新的 FLUX.1 Kontext 模型利用自然語言,透過提供一個可同時執行影像生成和編輯的單一模型,簡化這一過程。

NVIDIA 已與 Black Forest Labs 合作,運用 NVIDIA TensorRT 軟體開發套組與量化技術,針對 NVIDIA RTX GPU 進行 FLUX.1 Kontext [dev] 最佳化,以更低的 VRAM 需求提供更快的推論。

對於創作者與開發者而言,TensorRT 最佳化意味著 — 可直接在 RTX 驅動式機器上 — 完成更快的編輯、更流暢的迭代,以及更強大的控制能力。

FLUX.1 Kontext [dev] Flex:情境圖像生成

Black Forest Labs 於 5 月推出 FLUX.1 Kontext 系列影像模型,可同時接受文字和影像提示。

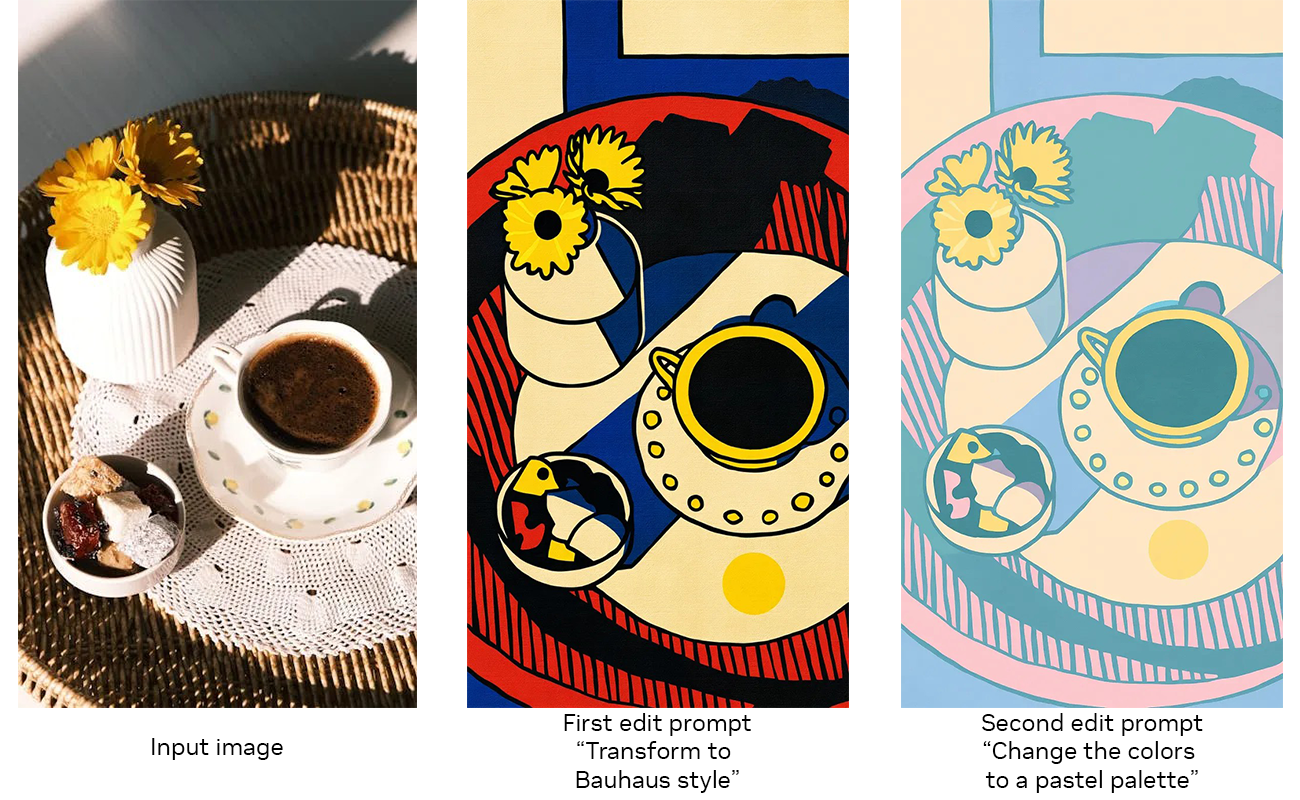

這些模型讓使用者可從參考影像開始,並以簡單語言引導編輯,無需微調或透過多個 ControlNet 來完成複雜的工作流程。

FLUX.1 Kontext 是一款開放權重的生成模型,運用引導式、逐步生成流程,為影像編輯建置,無論是微調細節或改造整個場景,都能更輕鬆地控制影像的演變方式。 由於模型接受了文字和影像輸入,使用者因此可輕鬆參考視覺概念,並引導其自然直覺地演變。如此一來,便可進行一致、高品質的影像編輯,並忠實於原創概念。

FLUX.1 Kontext 的關鍵功能包括:

- 角色一致性:保留多重場景和角度的獨特特徵。

- 本地化編輯:修改特定元素,無須改變影像的其餘部分。

- 風格轉移:將參考影像的外觀和感覺套用至新場景。

- 即時效能:低延遲生成,支援快速迭代和意見回饋。

Black Forest Labs 上週推出了 FLUX.1 Kontext 權重,已於 Hugging Face 開放下載,以及相應的 TensorRT 加速版本。

[dev] 模型強調靈活性和控制力。 它支援字體一致性、風格保留和本地化影像調整等功能,並整合了 ControlNet 功能,提供結構化視覺提示。

FLUX.1 Kontext [dev] 已支援 ComfyUI 與 Black Forest Labs Playground,NVIDIA NIM 微服務版本預計將於 8 月發布。

透過 TensorRT 加速技術,針對 RTX 最佳化

FLUX.1 Kontext [dev] 可簡化複雜的工作流程,加速創意的創作。 為了進一步精簡工作流程並提升易用性,NVIDIA 與 Black Forest Labs 合作將模型進行量化 - 降低對 VRAM 的需求,讓更多人能在本機執行 - 並透過 TensorRT 技術最佳化,將效能提升一倍。

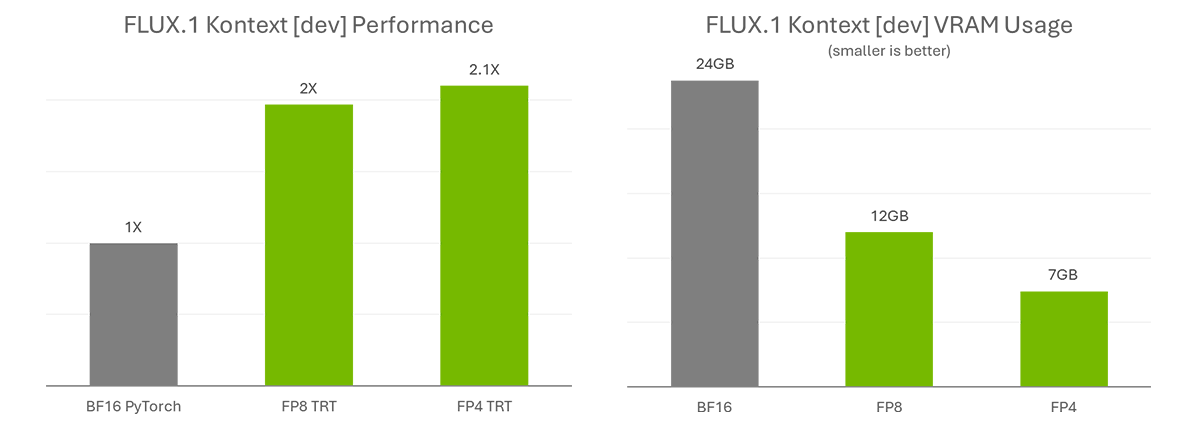

量化步驟可將 FP8 (Ada) 的模型大小從 24GB 縮小至 FP8(Ada)的 12GB 和 FP4(Blackwell)的 7GB。FP8 檢查點針對 GeForce RTX 40 系列 GPU 進行了最佳化,這些 GPU 的 Tensor Core 中配備了 FP8 加速器。FP4 檢查點基於相同理由,也針對 GeForce RTX 50 系列 GPU 最佳化,並採用一種名為 SVDQuant 的全新方法,保持高影像品質,同時縮小模型大小。

TensorRT — 是一款能存取 NVIDIA RTX GPU 中的 Tensor 核心 — 以實現最高效能的框架,與使用 PyTorch 執行原始 BF16 模型相比,速度提升超過 2 倍。

開始使用 FLUX.1 Kontext

FLUX.1 Kontext [dev] 已於 Hugging Face(Torch 與 TensorRT)開放下載。

有興趣測試這些模型的 AI 愛好者,可下載 Torch 版本,並在 ComfyUI 中使用。 Black Forest Labs 還提供了線上遊樂場,用於測試模型。

NVIDIA 正開發範例程式碼,讓進階使用者與開發者能輕鬆整合 TensorRT 管道至工作流程。請在本月下旬查看 DemoDiffusion 儲存庫。

但請耐心稍後,即將推出更多內容

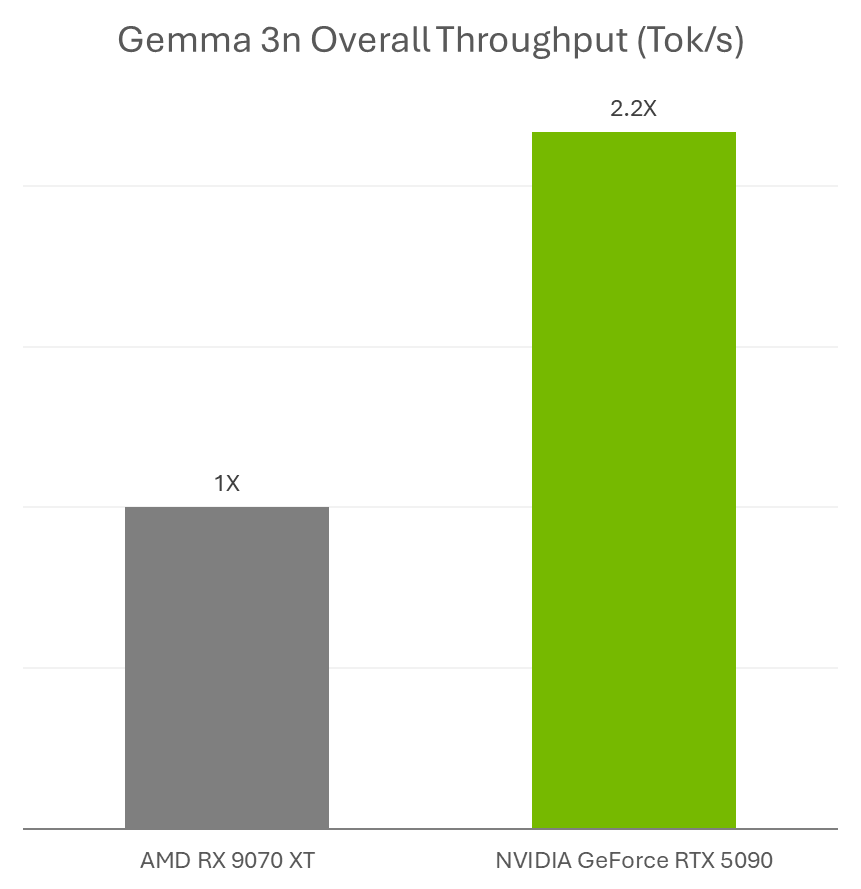

Google 上週宣佈推出 Gemma 3n,這是一款全新的多模式小型語言模型,非常適合在 NVIDIA GeForce RTX GPU 和 NVIDIA Jetson 平台上執行,用於邊緣 AI 與機器人技術。

AI 愛好者可在 Ollama 和 Llama.cpp 中使用搭載 RTX 加速技術的 Gemma 3n 模型,以及最愛的應用程式(例如 AnythingLLM 與 LM Studio)。

此外,開發者可運用 Ollama 輕鬆部署 Gemma 3n 模型,從 RTX 加速技術中獲益。 深入瞭解如何在 Jetson 與 RTX 上執行 Gemma 3n。

此外,NVIDIA 的隨插即用:Project G-Assist 外掛程式黑客松 — 將持續至 7 月 16 日(週三) — 邀請開發者探索 AI 並打造自訂的 G-Assist 外掛程式,將有機會贏得大獎。 請預留時間,參加 G-Assist Plug-In 線上研討會,時間為 7 月 10 日(週四)上午 1 點至2 點(台北時間),以深入瞭解 Project G-Assist 功能和基本原理,並參與現場問答場次。

加入 NVIDIA Discord 伺服器,與社群開發者和 AI 愛好者交流,討論 RTX AI 的潛力。

RTX AI Garage 部落格系列每週都會推出社群驅動的 AI 創新成果和內容,讓那些有興趣的人瞭解更多有關 NVIDIA NIM 微服務和 AI Blueprints,以及在 AI PC和工作站上建置 AI 代理、創意工作流程、數位人、效率應用程式等內容。

關注 NVIDIA AI PC 在 Facebook、Instagram、TikTok 和 X 的外掛程式 ,以及訂閱 RTX AI PC 電子報以隨時掌握最新消息。

在 LinkedIn 和 X 上關注 NVIDIA 工作站。

請參閱更多軟體產品資訊通知。