NVIDIA 正與全球企業並肩建造人工智慧(AI)工廠,加快訓練及部署採用最新訓練與推論技術的下一代 AI 應用。

NVIDIA 的 Blackwell 架構專為滿足這些對效能需求日漸升高的新型應用而打造。在最新一輪 MLPerf Training 測試中,同時也是自 2018 年推出這項基準測試以來的第 12 輪測試,NVIDIA AI 平台在每項基準測試中均展現出最大規模效能,並驅動該基準測試中最具挑戰性的大型語言模型(LLM)測試項目「Llama 3.1 405B 預訓練」的所有結果。

NVIDIA 平台是唯一在每項 MLPerf Training v5.0 基準測試中均有提交結果的平台,這突顯其在各種 AI 工作負載中的卓越效能與任務多樣性,包括大型語言模型、推薦系統、多模態大型語言模型、物體偵測與圖神經網路(GNN)。

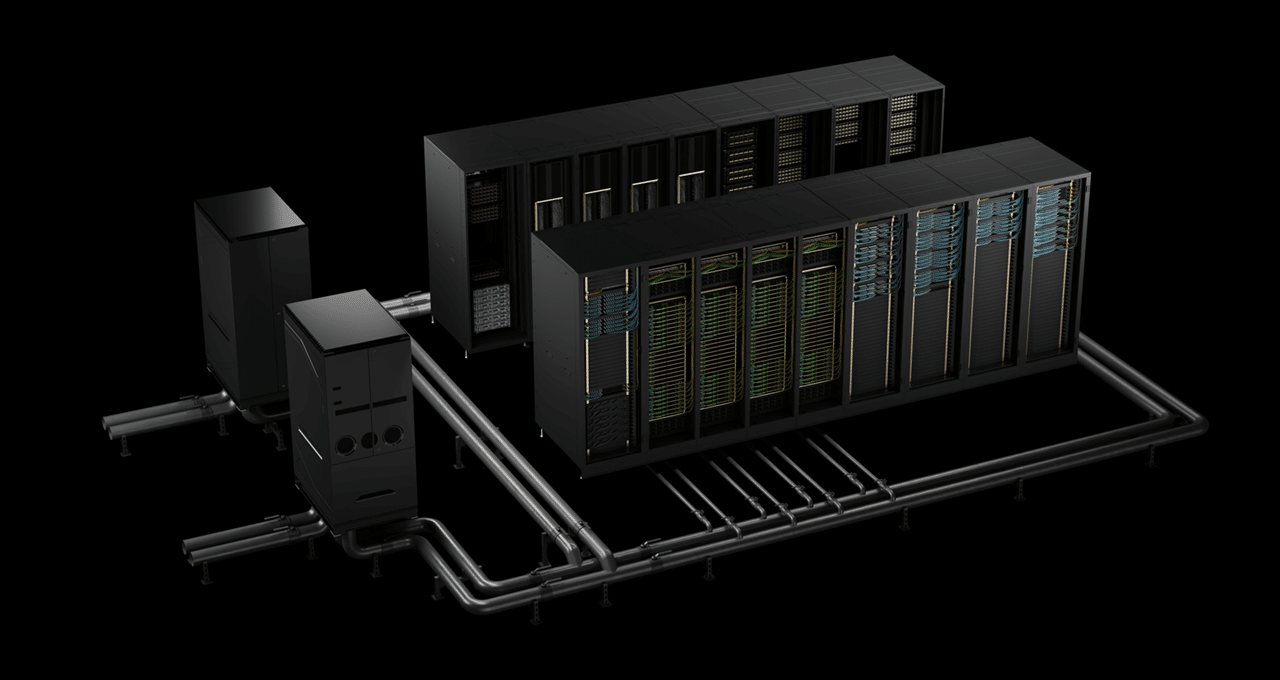

這次大規模提交的測試結果使用兩部搭載 NVIDIA Blackwell 平台的 AI 超級電腦:Tyche 採用 NVIDIA GB200 NVL72 機架規模系統打造,Nyx 則以 NVIDIA DGX B200 系統為基礎。此外,NVIDIA 也與 CoreWeave 和 IBM 合作,提交 GB200 NVL72 的測試結果,共使用 2,496 顆 Blackwell GPU 與 1,248 顆 NVIDIA Grace CPU。

在最新的 Llama 3.1 405B 預訓練基準測試中,Blackwell 的效能較上一代架構在相同規模下高出 2.2 倍。

在 Llama 2 70B LoRA 微調基準測試中,搭載 8 顆 Blackwell GPU 的 NVIDIA DGX B200 系統效能,較上一輪使用相同數量 GPU 的測試結果提升達 2.5 倍。

這些效能上的躍進突顯 Blackwell 架構的優勢,包括高密度液冷機架、每個機架搭配 13.4TB 的一致性記憶體、用於垂直擴展的第五代 NVIDIA NVLink 及 NVIDIA NVLink Switch 互連技術,以及用於橫向擴展的 NVIDIA Quantum-2 InfiniBand 網路技術。此外,NVIDIA NeMo Framework 軟體堆疊的創新技術,提升了下一代多模態大型語言模型訓練的水準,這對於將代理型 AI 應用推向市場而言至關重要。

這些由代理型 AI 驅動的應用,有朝一日將在 AI 工廠中運行,而這些 AI 工廠正是推動代理型 AI 經濟的引擎。這些全新應用將產生各種詞元(token)與寶貴的智慧,可應用於幾乎所有產業與學術領域。

NVIDIA 資料中心平台包含 GPU、CPU、高速互連架構和網路技術,以及種類豐富的軟體,包括 NVIDIA CUDA-X 函式庫、NeMo Framework、NVIDIA TensorRT-LLM 與 NVIDIA Dynamo。這套高度最佳化的硬體與軟體,使得組織能更快速地訓練及部署模型,顯著加快創造價值的時間。

NVIDIA 的合作夥伴生態系廣泛參與這輪 MLPerf 測試。除了與 CoreWeave 和 IBM 合作提交的測試結果外,華碩、思科、戴爾科技集團、技鋼科技、Google Cloud、慧與科技、Lambda、聯想集團、Nebius、Oracle Cloud Infrastructure、雲達科技和美超微亦交出亮眼的測試結果。

進一步了解 MLPerf 基準測試。