大型語言模型 (LLM) 經過含數十億個 Token 的資料集訓練,可生成高品質內容。這類模型是諸多最熱門 AI 應用程式的骨幹,包括聊天機器人、助理與程式碼生成器等。

AnythingLLM 是現今最簡單易用的 LLM 使用方式之一,也是為希望直接在 PC 使用多合一隱私導向 AI 助理愛好者所打造的桌上型應用程式。

NVIDIA GeForce RTX 與 NVIDIA RTX PRO GPU 新增對 NVIDIA NIM 微服務的支援,現在 AnythingLLM 使用者甚至可獲得更快速的效能,以及反應更靈敏的本機 AI 工作流程。

AnythingLLM 是什麼?

AnythingLLM 是多合一的 AI 應用程式,可讓使用者執行本機 LLM、檢索增強生成 (RAG) 系統及代理型工具。

它是使用者慣用 LLM 及其資料之間的橋樑,支援取用工具 (稱為 skill),因此利用 LLM 處理以下特定任務時變得更簡單有效率,例如:

- 解答問題:獲得 Llama 與 DeepSeek R1 等頂尖 LLM 提供的問題解答,而且不會產生任何成本。

- 個人資料查詢:私下使用 RAG 查詢內容,包括 PDF、Word 檔案與程式碼庫等。

- 文件摘要:生成研究論文這類冗長文件的摘要。

- 資料分析:載入檔案並利用 LLM 查詢檔案,擷取資料深入解析。

- 代理型動作:利用本機或遠端資源動態研究內容,並根據使用者提示執行生成式工具與動作。

AnythingLLM 可連接多種開源本機 LLM,以及雲端的大型 LLM,包括 OpenAI、Microsoft 與 Anthropic 提供的雲端 LLM。此外,這款應用程式還可取用 skill,透過社群中心擴大代理型 AI 功能範圍。

AnythingLLM 可一鍵安裝,還能以獨立應用程式或瀏覽器擴充功能的方式發佈,融入直覺式體驗,無需複雜的設定程序,因此是 AI 愛好者的最佳選擇,尤其適合配備 GeForce RTX 與 NVIDIA RTX PRO GPU 系統的使用者。

RTX 驅動 AnythingLLM 加速技術

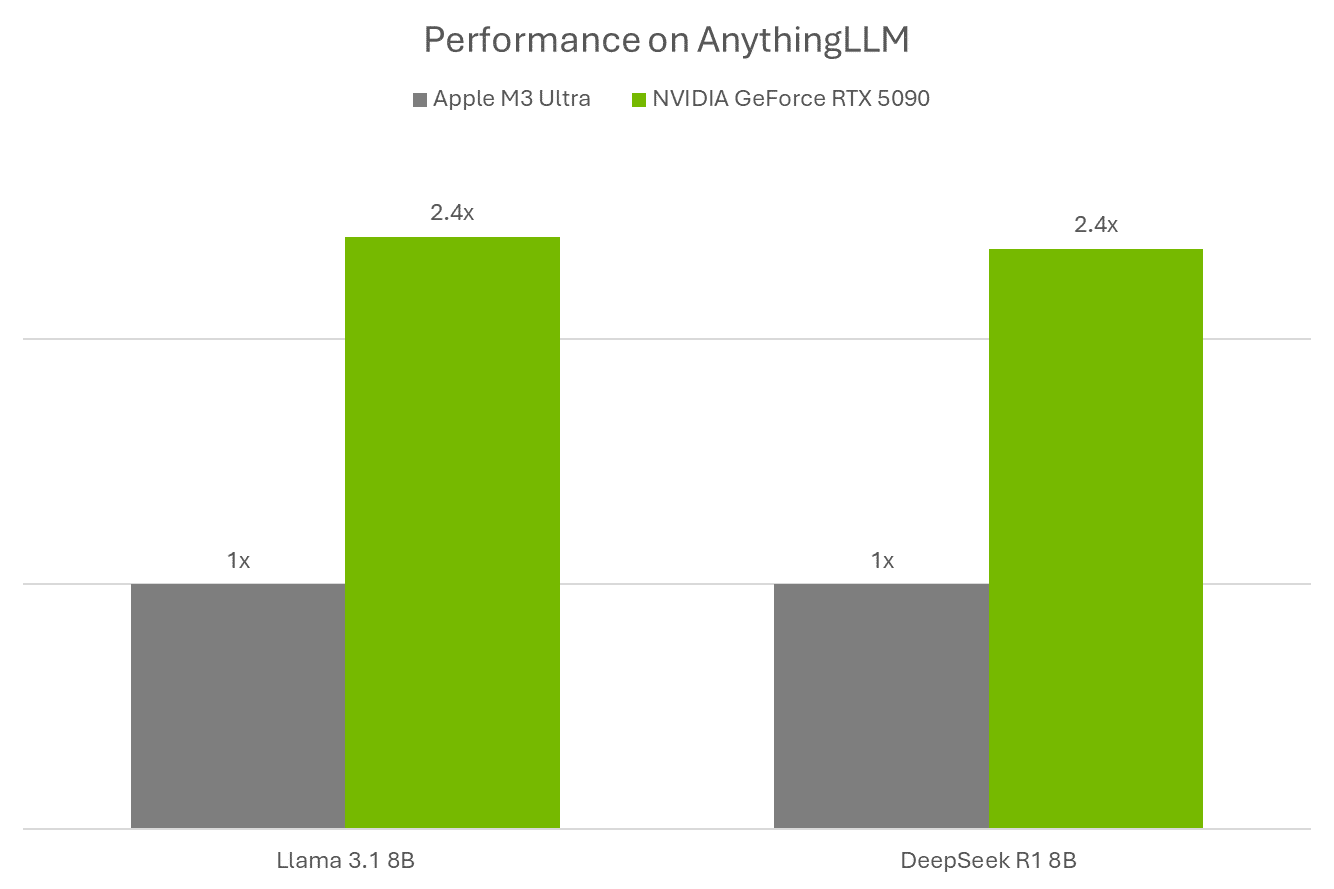

GeForce RTX 與 NVIDIA RTX PRO GPU 可讓在 AnythingLLM 執行 LLM 與代理的效能大幅提高,並可利用為加速 AI 所設計的 Tensor 核心加快推論速度。

AnythingLLM 透過 Ollama 執行 LLM,利用 Llama.cpp 與 ggml tensor 函式庫在裝置端執行,加速機器學習。

Ollama、Llama.cpp 與 GGML 針對 NVIDIA RTX GPU 與第五代 Tensor 核心最佳化。GeForce RTX 5090 的效能為 Apple M3 Ultra 的 2.4 倍。

NVIDIA 新增全新的 NIM 微服務與參考工作流程 (例如與日俱增的 AI Blueprint 函式庫) 後,AnythingLLM 這類工具便可開啟更豐富的多模式 AI 使用案例。

AnythingLLM — 現已整合 NVIDIA NIM 技術

AnythingLLM 近期新增對 NVIDIA NIM 微服務的支援。這種微服務是效能最佳化的預封裝生成式 AI 模型,隨附精簡的 API,輕輕鬆鬆便可在 RTX AI PC 展開 AI 工作流程。

NVIDIA NIM 非常適合希望在工作流程快速測試生成式 AI 模型的開發者。它們提供的容器應有盡有,開發者不必尋找合適的模型、不用下載全部檔案,也不需要思考如何連接一切元件。此外,它們可在雲端與 PC 執行,因此輕輕鬆鬆便可在本機設計原型,然後在雲端部署。

透過在 AnythingLLM 簡單易用的 UI 內提供,使用者可快速測試及實驗。接著,使用者可利用 AnythingLLM 將它們連接至工作流程,或是使用 NVIDIA AI Blueprint 與 NIM 文件和程式碼範例,將它們直接插入應用程式或專案。

探索多種提升 AI 驅動工作流程的 NIM 微服務,其中包括語言生成、影像生成、電腦視覺以及語音處理。

RTX AI Garage 部落格系列每週都會推出社群驅動的 AI 創新成果和內容,讓那些想了解更多有關 NIM 微服務和 AI Blueprint,以及在 AI PC 和工作站上建置 AI 代理、創意工作流程、數位人、生產力應用程式等內容。

關注 NVIDIA AI PC 的 Facebook、Instagram、TikTok 和 X ,以及訂閱 RTX AI PC 電子報以隨時掌握最新消息。