Black Forest Labs 的 FLUX.1 Kontext [dev] 影像編輯模型現已推出 NVIDIA NIM 微服務。

FLUX.1 模型讓使用者能以簡單語言編輯現有影像,無需微調或複雜的工作流程。

部署強大的 AI 需要策劃模型變體、自適應以管理所有輸入和輸出資料,以及量化以降低 VRAM 需求。 必須轉換模型,才能與最佳化推論後端軟體配合使用,並連接至全新的 AI 應用程式設計介面。

FLUX.1 Kontext [dev] NIM 微服務簡化了這個流程,解鎖更快的生成式 AI 工作流程,並針對 RTX AI PC 最佳化。

適用於 RTX AI PC 的 NVIDIA NIM 微服務與 AI Blueprint 是什麼?

Kontext 中的生成式 AI

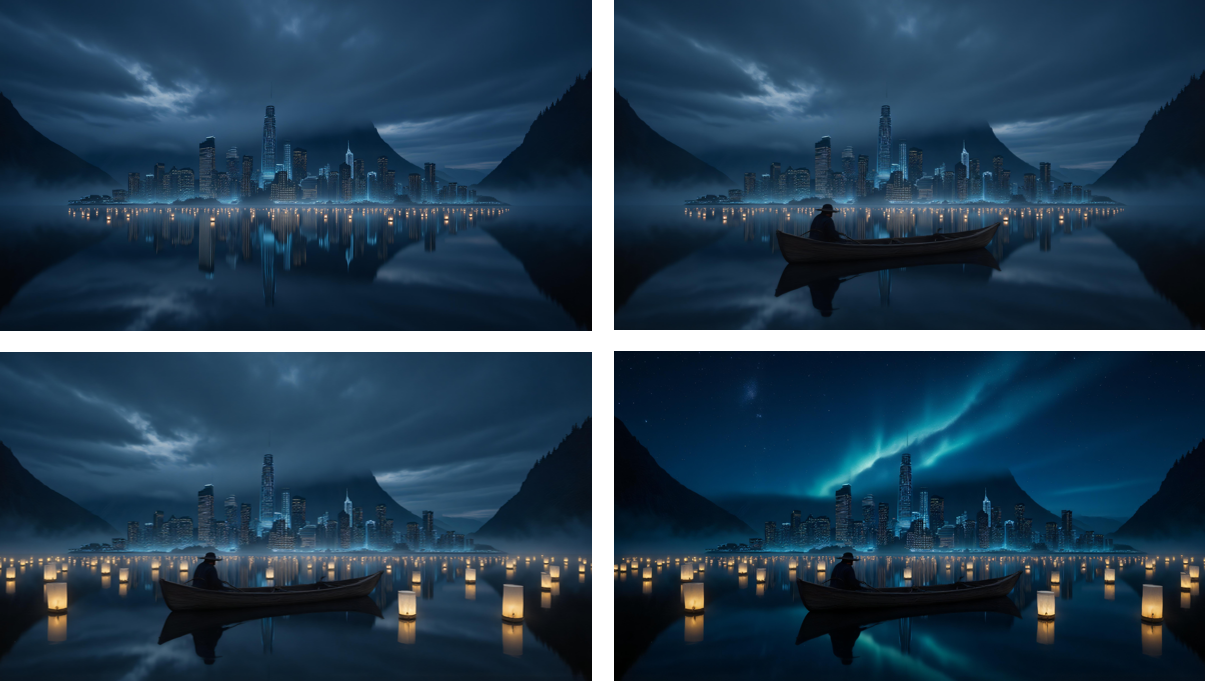

FLUX.1 Kontext [dev] 是一款為影像編輯打造的開放權重生成式模型。 它具備引導式的逐步生成流程,無論是微調小細節還是改造整個場景,都能更輕鬆地控制影像的演變方式。

由於模型接受了文字和影像輸入,使用者因此可輕鬆參考視覺概念,並引導其自然直覺地演變。如此一來,便可進行一致、高品質的影像編輯,並忠實於原創概念。

FLUX.1 Kontext [dev] NIM 微服務提供預先封裝的最佳化檔案,可供使用者透過 ComfyUI NIM 節點一鍵下載,讓使用者能輕鬆存取。

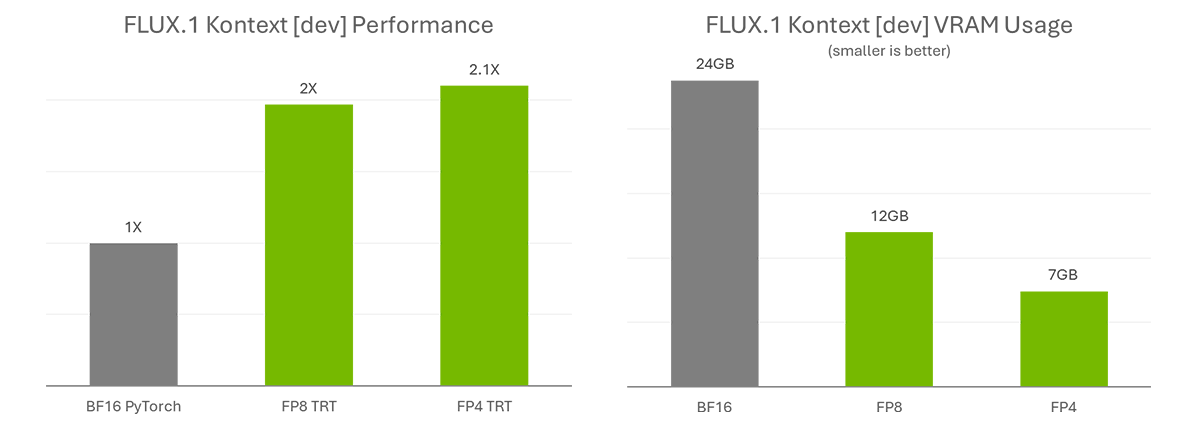

NVIDIA 與 Black Forest Labs 合作量化 FLUX.1 Kontext [dev],將 FP8 (NVIDIA Ada Generation GPU) 的模型大小從 24GB 縮小至 12GB,並將 FP4 (NVIDIA Blackwell 架構) 的模型大小縮小至 7GB。FP8 檢查點針對 GeForce RTX 40 系列的 GPU 進行了最佳化,這些 GPU 的 Tensor Core 中配備了 FP8 加速器。FP4 檢查點針對 GeForce RTX 50 系列 GPU 進行了最佳化,並採用名為 SVDQuant 的全新方法,在保持影像品質的同時,縮小模型大小。

此外,NVIDIA TensorRT 是一款可存取 NVIDIA RTX GPU 中的 Tensor 核心,以實現最高效能的框架,與使用 PyTorch 執行原始 BF16 模型相比,可提供超過 2 倍的加速功能。

這些顯著的效能提升,過去僅限於具備先進 AI 基礎架構知識的 AI 專家和開發者。 透過 FLUX.1 Kontext [dev] NIM 微服務,連愛好者也能以更佳的效能節省時間。

獲得 NIMble

FLUX.1 Kontext [dev] 現已在 Hugging Face 提供 TensorRT 最佳化功能與 ComfyUI。

若要開始使用,請依照 ComfyUI NIM 節點的 GitHub 頁面上的指示操作:

- 安裝 NVIDIA AI Workbench。

- 獲得 ComfyUI。

- 透過 App 中的 ComfyUI 管理器安裝 NIM 節點。

- 在 Black Forest Labs 的 FLUX.1 Kontext 的 [dev] Hugging Face 上接受模型授權。

- 該節點將準備所需的工作流程,並在按一下「執行」後,協助下載所有必要的模型。

NIM 微服務針對 NVIDIA GeForce RTX 與 RTX PRO GPU 的效能進行最佳化,並包含 AI 社群的熱門模型。 在 GitHub 和 build.nvidia.com 探索 NIM 微服務。

RTX AI Garage 部落格系列每週都會推出社群驅動的 AI 創新成果和內容,讓那些有興趣的人瞭解更多有關 NVIDIA NIM 微服務和 AI Blueprint,以及在 AI PC和工作站上建置 AI 代理、創意工作流程、效率應用程式等內容。

在 Facebook、Instagram、TikTok 和 X 上關注 NVIDIA AI PC,並訂閱 RTX AI PC 電子報以隨時掌握最新消息。加入 NVIDIA Discord 伺服器,與社群開發者和 AI 愛好者交流,討論 RTX AI 的潛力。

在 LinkedIn 和 X 上關注 NVIDIA 工作站。

請參閱軟體產品資訊的相關通知。