生成式 AI 驅動的筆記型電腦和 PC,是遊戲、內容創作、生產力與開發日新月異的推手。目前,全球有逾 600 款 Windows App 和遊戲,在超過 1 億部 GeForce RTX AI PC 以本機方式執行 AI,實現快速、可靠且低延遲的效能。

NVIDIA 與 Microsoft 在 Microsoft Ignite 大會發表的工具,協助 Windows 開發者在 RTX AI PC 快速打造並最佳化 AI 驅動的 App,帶動本機 AI 普及化。這些新工具幫助應用程式與遊戲開發者駕馭強大的 RTX GPU,為各種應用情境加速複雜的 AI 工作流程,例如 AI 代理、App 助理與數位人。

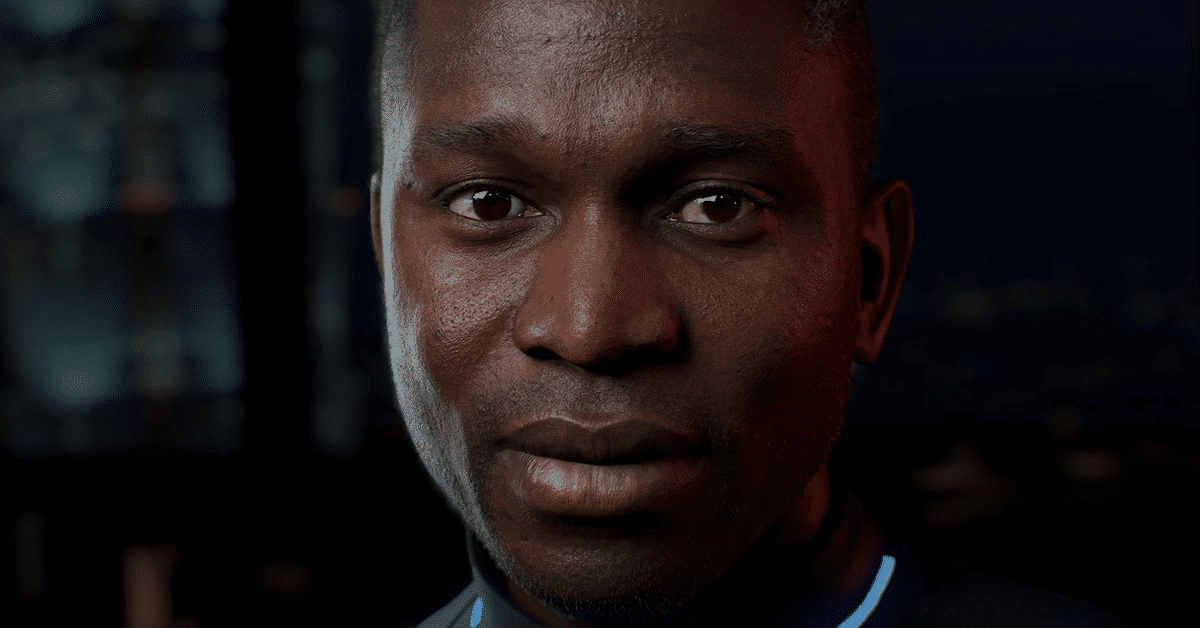

RTX AI PC 利用多模態小型語言模型推動數位人發展

NVIDIA ACE 這個數位人技術套件,為代理、助理與虛擬替身注入生命。數位人必須能夠像人類一樣透過視覺感知世界,理解力才能更上層樓,進而以更強的情境感知能力回應。

若要讓數位人互動更逼真,必須有能夠更細膩感知及理解周遭環境的技術。NVIDIA 為此開發的多模態小型語言模型,文字和影像處理能力兼備,不僅角色扮演能力出眾,還已針對加速回應最佳化。

即將問市的 NVIDIA Nemovision-4B-Instruct 模型採用最新的 NVIDIA VILA 與 NVIDIA NeMo 架構,經過蒸餾、剪枝與量化後可縮小,符合在 RTX GPU 執行需要的尺寸,並且實現開發者要求的精準度。這款模型可讓數位人理解真實世界與螢幕呈現的視覺影像,然後提供相關的回應。多模態為代理工作流程奠定了基礎,讓我們得以一窺數位人未來如何幾乎不靠使用者協助,就能順利推理及採取行動。

此外,NVIDIA 還推出 Mistral NeMo Minitron 128k Instruct 系列;這個小型語言模型套件上下文豐富,是專為最佳化的高效數位人互動而設計,近期即將問世。這些模型有 8B、4B 與 2B 參數幾個版本,提供靈活彈性的選項,可讓 RTX AI PC 在速度、記憶體使用量與精準度之間取得平衡。該模型一次就能將大型資料集處理完畢,過程不需要分割及重新組合。這些模型採用 GGUF 格式,不僅讓低功耗設備效率更高,還與多種程式設計語言相容。

適用於 Windows 的 NVIDIA TensorRT Model Optimizer 讓生成式 AI 如虎添翼

開發者於 PC 環境導入模型時困難重重,包括在本機執行 AI 所需的記憶體和運算資源有限。他們還希望將模型普及化,並且儘量讓精準度不打折扣。

NVIDIA 今天發表了 NVIDIA TensorRT Model Optimizer (ModelOpt) 更新,讓 Windows 開發者以更完善的方式針對 ONNX Runtime 部署將模型最佳化。

TensorRT ModelOpt 最近更新之後,可讓模型最佳化並轉換為 ONNX 檢查點,利用 CUDA、TensorRT 與 DirectML 這類 GPU 執行提供者,在 ONNX 執行環境部署模型。

TensorRT-ModelOpt 包含先進的量化演算法,例如 INT4-Activation Aware Weight Quantization (AWQ)。相較於 Olive 等其他工具,這個新方法進一步減少模型記憶體的實體佔用空間,並且提升 RTX GPU 輸送量的效能。相較於 FP16 模型,這些模型部署時的記憶體實體佔用空間最高可縮小 2.6 倍。這樣一來,模型不僅輸送速度更快,精準度受影響的程度也降到最低,還可搭配各式各樣的PC運作。

深入瞭解 Microsoft 系統的開發者,無論是使用 Windows RTX AI PC 或搭載 NVIDIA Blackwell 的 Azure 伺服器,如何全面改變使用者每天與 AI 互動的方式