編者按:這篇文章屬於「解碼 AI 」系列,該系列文章會以簡單易懂的方式解碼 AI,同時展示適用於 NVIDIA RTX PC 和工作站使用者的全新硬體、軟體、工具和加速功能。

對於簡化及最佳化生成式人工智慧開發工具的需求正在急遽成長。以檢索增強生成技術 (RAG) (一種利用特定外部來源擷取事實,以提高人工智慧生成模型準確性及可靠性的技術) 為基礎的應用程式和客製化模型,讓開發人員能夠根據特定需求調整人工智慧模型。

雖然這類工作過去可能需要複雜的設定,但新工具讓這項工作變得比以往更容易。

NVIDIA AI Workbench可協助使用者打造自己的 RAG 專案、自訂模型等,簡化人工智慧開發人員的工作流程。這是本月初在台北國際電腦展所發佈之 RTX AI Toolkit 的其中一項工具,是一套用於自訂、最佳化和部署人工智慧功能的工具和軟體開發套件。人工智慧和機器學習開發平台可消除技術工作的複雜性,讓專家不致迷失方向,也不會讓初學者望之卻步。

什麼是 NVIDIA AI Workbench?

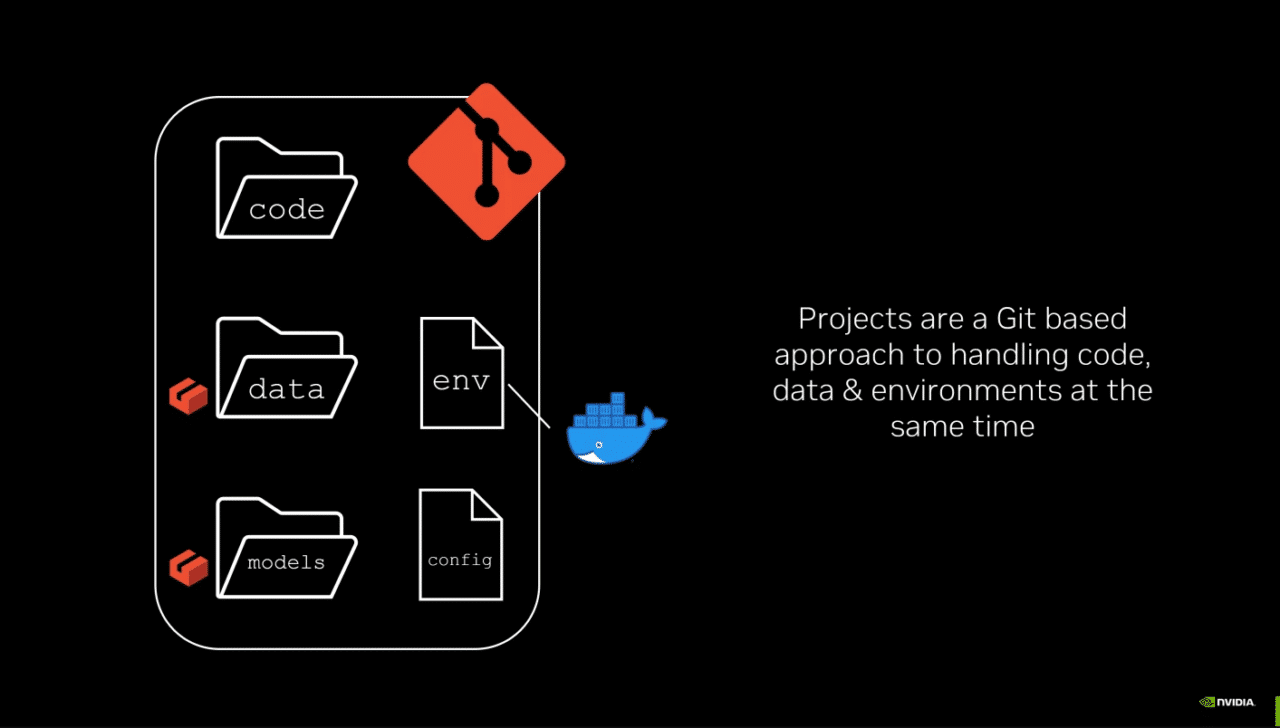

NVIDIA AI Workbench可免費使用,讓使用者能夠在筆記型電腦、工作站、資料中心和雲端等所選的 GPU 系統上,開發、實驗、測試人工智慧應用程式並建立人工智慧應用程式原型。為跨人員和跨系統建立、使用和共享採用 GPU 的開發環境提供了全新方法。

只要幾分鐘的簡單安裝,使用者就能在本機或遠端機器上啟動並執行 AI Workbench。接著即可開始新專案,或從 GitHub 上的範例複製專案。一切都透過 GitHub 或 GitLab 運作,因此使用者可以輕鬆協作和分配工作。深入瞭解如何開始使用AI Workbench。

NVIDIA AI Workbench如何協助解決人工智慧專案的挑戰

開發人工智慧工作負載從初期就需要人工作業,且通常流程很複雜。

設定 GPU、更新驅動程式和管理版本不相容性有時相當麻煩。在不同系統間重製專案時,可能需要反覆執行人工作業流程。複製專案時,如資料片段和版本控制的問題,也可能會阻礙協作。不同的設定流程、移動認證和機密,以及環境、資料、模型和檔案位置的變化,都會限制專案的可攜性。

AI Workbench讓資料科學家和開發人員能更輕鬆地跨異質平台管理工作和協作。此平台整合並自動化開發流程的各個層面,提供以下優勢:

- 易於設定:AI Workbench簡化了設定 GPU 加速開發人員環境的流程,即使是技術知識有限的使用者也能輕鬆使用。

- 流暢協作:AI Workbench與 GitHub 和 GitLab 等版本控制和專案管理工具整合,減少協作時的摩擦。

- 從本機擴展至雲端時保持一致: AI Workbench可確保多個環境的一致性,支援從本機工作站或 PC 向上或向下擴充到資料中心或雲端。

使用 RAG 處理文件變得前所未有地簡單

NVIDIA 提供樣本開發工作台專案,協助使用者開始使用AI Workbench。混合式 RAG 工作台專案就是一個例子:此專案會在使用者的本機工作站、PC 或遠端系統上執行以文字為基礎的自訂 RAG Web 應用程式,其中包含一份使用者文件。

每個工作平台專案都在「容器」中執行,該軟體包含執行人工智慧應用程式所需的所有元件。混合式 RAG 樣本將主機上的 Gradio 聊天介面前端與容器化 RAG 伺服器配對,而後端則負責服務使用者的要求,並在向量資料庫和選定的大型語言模型之間路由查詢。

此工作平台專案支援 NVIDIA GitHub 頁面上提供的各種 LLM。此外,該專案的混合式特性,讓使用者可以選擇在何處執行推論。

開發人員可以在主機上執行嵌入式模型,然後在 Hugging Face 文字生成推論伺服器上執行本機推論,也可以使用 NVIDIA API 目錄等 NVIDIA 推論端點,或使用 NVIDIA NIM 等自託管微服務或第三方服務,在目標雲端資源上執行推論。

混合式 RAG 工作平台專案也包含:

- 效能指標:使用者可以評估 RAG 和非 RAG 使用者查詢在每種推論模式中的表現。追蹤的指標包括擷取時間、到第一個權杖的時間 (TFT) 和權杖速度。

- 擷取透明度:面板會顯示從向量資料庫中與情境相關度最高的內容擷取的確切文字片段,這些片段會匯入 LLM,並改善回應和使用者查詢的相關性。

- 自訂回應:可以使用多種參數調整回應,例如權杖生成數量最大值、溫度和頻率懲罰。

若要開始執行此專案,只需在本機系統上安裝AI Workbench 。您可以將混合式 RAG 工作平台專案從 GitHub 導入使用者帳號,並複製到本機系統。

更多資源請參閱「解碼 AI 」使用者指南。此外,社群成員也提供實用的教學影片,例如下方 Joe Freeman 的教學影片。

自訂、最佳化、部署

開發人員通常會針對特定使用案例自訂人工智慧模型。微調是一種透過額外資料訓練來改變模型的技術,可用於風格轉移或改變模型行為。AI Workbench也有助於進行微調。

Llama-factory AI Workbench專案支援 QLoRa,這是一種微調方法,可將各種模型的記憶體需求降到最低,並透過簡單的圖形使用者介面進行模型量化。開發人員可以使用公開或自己的資料集來滿足應用程式的需求。

微調完成後,可將模型量化以提升效能並減少記憶體使用量,然後部署至原生 Windows 應用程式進行本機推論,或部署至 NVIDIA NIM 進行雲端推論。在 NVIDIA RTX AI Toolkit 儲存庫中找到此專案的完整教學。

真正的混合式:在任何地方執行人工智慧工作負載

上述 Hybrid-RAG 工作台專案不只以單一方式混合。除了提供推論模式選擇之外,專案還可以在 NVIDIA RTX 工作站和 GeForce RTX PC 上本機執行,或擴充至遠端雲端伺服器和資料中心。

所有工作平台專案皆可在使用者選擇的系統上執行,無需設定基礎架構,減少使用者額外負荷。在AI Workbench快速入門指南中找到更多微調和自訂化內容的範例和說明。

生成式人工智慧正在轉變各種遊戲、視訊會議和互動式體驗。訂閱 「解碼 AI」電子報,瞭解最新消息與未來趨勢。