在 Steve Jobs 發布一台可以放入口袋的運算機的 27 年前,物理學家 Paul Benioff 發表了一篇論文,表明理論上可以構建一個更小更強大的系統——一個量子運算機。

Benioff 於 1980 年描述的概念是利用亞原子物理學命名,這個概念依然在驅動著今天的研究,包括努力創造下一個運算領域大事件:一個可以在某些方面讓運算看起來像算盤的古樸的系統。

諾貝爾物理學獎得主 Richard Feynman 通過引人入勝的演講,為廣大聽眾帶來了物理學,他幫助建立了這個領域,勾勒出此類系統如何比傳統運算機更有效地模擬離奇的量子現象。

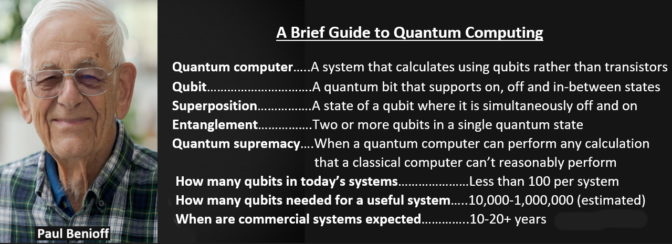

量子運算是什麼?

量子運算使用亞原子粒子的物理學領域來執行複雜的並行運算,從而取代了當今運算機系統中更簡單的晶體管。

量子運算機使用量子比特運算,運算單元可以打開,關閉或之間的任何值,而不是傳統運算機中的字符,要么打開,要么關閉,要么是 1,要么是 0。量子比特居於中間態的能力(稱為“態疊加”),這為運算方程增加了強大的功能,使量子運算機在某種數學運算中更勝一籌。

量子運算機可以通過量子比特進行運算,這種運算過程需要耗費傳統運算機無限長的時間,有時甚至根本無法完成。

例如,如今的運算機使用 8 位表示介於 0 到 255 之間的任何數字。得益於態疊加原理,量子運算機可以使用八個量子比特同時表示 0 到 255 之間的每個數字。

這是一項與運算中的並行性類似的功能:所有可能性都是一次性運算,而非按順序運算,從而大幅增加速度。

因此,經典運算機每次執行一個長除法運算以分解一個龐大的數字,而量子運算機卻可以僅通過一個步驟獲得答案。砰!

這意味著量子運算機可以重塑整個領域,例如密碼學,這些領域均基於對當今不可能處理的龐大數據進行分解。

微型模擬的一大作用

這可能只是個開始。一些專家認為,量子運算機將突破目前阻礙化學、材料科學以及任何涉及量子力學納米級大小的世界模擬的極限。

量子運算機甚至可以幫助工程師對他們在當今最小的晶體管中開始發現的量子效應進行更精細的量子效果模擬,從而延長半導體的使用壽命。

事實上,專家表示量子運算機最終不會取代經典運算機,它們將相互補充。有些人預測,量子運算機將用作加速器,就像 GPU 加速當今的運算機一樣。

量子運算是如何工作的?

不要指望用從當地電子商店的打折箱裡回收的零件來搭建自己的量子運算機,像自己動手組裝一台個人運算一樣。

目前,少數運行中的系統通常需要冷藏,以在絕對零度以上一點創造工作環境。他們需要這種寒冷的運算環境來處理為這些系統提供動力的脆弱的量子態。

要說構建量子運算機有多難,一個原型是在兩個激光器之間懸浮一個原子以創建一個量子比特。您可以在家裡的工作室試試!

量子運算創造了納米級別非常強大卻有著致命弱點的東西-量子糾纏,那是當一個量子態中存在兩個或更多的量子比特的情況,這種情況有時由波長僅一毫米的電磁波來測量。

如果波的能量稍微大一些就會失去量子糾纏或疊加態,或者兩者同時失去。結果就會出現一種叫做量子退相干的噪音狀態,在量子運算中等同於運算藍屏死機。

量子運算機現在的狀態如何?

阿里巴巴、Google、Honeywell、IBM 、IonQ和Xanadu等少數幾家公司都運營著早期幾代量子運算機。

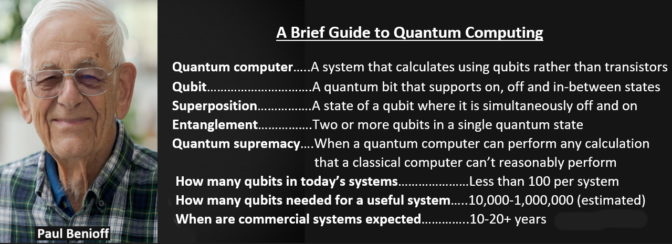

如今,他們提供了數十個量子比特。但雜訊可能較高,導致它們有時不穩定。 如要可靠地解決實際問題,系統需要數万或數十萬個量子比特。

專家認為,要進入量子運算機真正有用的高保真時代,還得需要幾十年。

關於何時達到所謂量子運算霸權(量子運算機執行經典運算機無法執行的任務的時間)的預測是業界熱烈討論的問題。

加速量子電路模擬

好消息是 AI 和機器學習領域聚焦於 GPU 等加速器,這些加速器可以執行量子運算機用量子比特運算的許多類型的運算。

現在,經典運算機已經找到了使用 GPU 實現量子模擬的方法。例如,NVIDIA 在我們的內部 AI 超級運算機 Selene 上進行前沿的量子模擬。

NVIDIA 在 GTC 主題演講上宣布推出 cuQuantum SDK,目的是加速在 GPU 上運行的量子電路模擬。早期研究表明,cuQuantum 能夠提供許多量級的加速。

SDK 採用一種不可知論的方式為用戶提供了可以選擇的最適合其方法的工具。例如,態向量可提供高保真結果,但其內存需求會隨著量子比特數量的增大呈指數級增長。

這會在如今最大的傳統超級運算機創造約 50 個量子比特的實際限制。不過,我們已經(見下文)看到使用 cuQuantum 加速使用這種方法的量子電路模擬的顯著結果。

來自 Jülich 超級運算中心的研究人員在 GTC session E31941 深入講解態向量法的工作。

一個較新的方法是張量網絡模擬,它使用更少的內存和更多的運算來執行類似的工作。

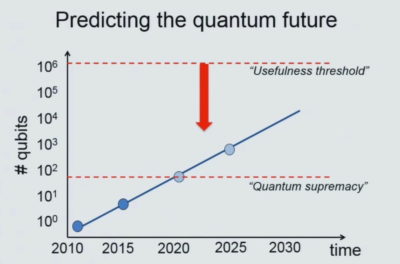

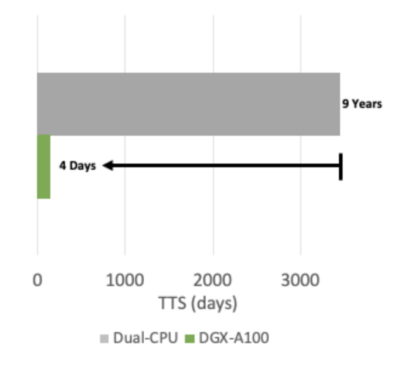

利用這種方法,NVIDIA 和加州理工學院使用運行在 NVIDIA A100 Tensor Core GPU 上的 cuQuantum 完成了對最先進的量子電路模擬器的加速。在 Selene 上,這個實驗在 9.3 分鐘便從 Google Sycamore 電路的全電路模擬中生成了一個樣本,而18 個月前,專家認為需要使用數百萬個 CPU 核心花費數天時間才能完成這項任務。

加州理工學院的研究科學家 Johnnie Gray 說:“通過使用 Cotengra/Quimb 包、NVIDIA新發布的 cuQuantum SDK 和 Selene 超級運算機,我們在10 分鐘內生成了 Sycamore 量子電路樣本,深度 m=20”。

加州理工學院化學教授 Garnet Chan 表示:“這為量子電路模擬性能設定了基準,並將有助於提升我們驗證量子電路行為的能力,從而推動量子運算領域的發展。”Garnet Chan 教授的實驗室是這項工作的主辦方。

NVIDIA 預計,cuQuantum 的性能提升和易用性將使其成為研究前沿每個量子運算框架和模擬器的基礎元素。