全球最頂尖的其中一間科技公司,不見得每天都會強調你家產品有著哪些優點。

Intel在 5月中就這麼做了,將他們兩款最為昂貴高階的 CPU 與 NVIDIA 的 GPU 在推論能力方面進行比較。

硬體評測網站 Anandtech 表示,Intel 將兩個極為耗電的最高端 CPU 組合起來(估算兩個 CPU 加起來要價五萬到十萬美元),才能達到單個主流 V100 NVIDIA GPU 的運算效能。Intel 透過這場比較效能的結果,也突顯出專為推論作業打造的 NVIDIA T4 GPU 具有哪些顯著優勢。與單個最高階 CPU 相比,它們不僅速度更快,能源使用效率也高出七倍,在成本效益方面更大幅提高了一級。

在人工智慧支援的服務大幅成長的情況下,推論表現十分重要。Intel 最新的 Cascade Lake CPU 加入了提升推論表現的新指令,成為執行推論作業表現最佳的 CPU。可是它跟 NVIDIA 針對深度學習進行優化後的 Tensor Core GPU 一比,簡直難以望其項背。

簡單來說,推論(也就是預測)是對神經網路進行訓練後,它所做出的「模式辨識」。人工智慧模型也是藉此提供智慧功能給應用程式,例如偵測金融交易中的詐欺活動、以自然語言進行對話來搜尋網路,以及透過預測分析在製造活動中斷前進行修復。

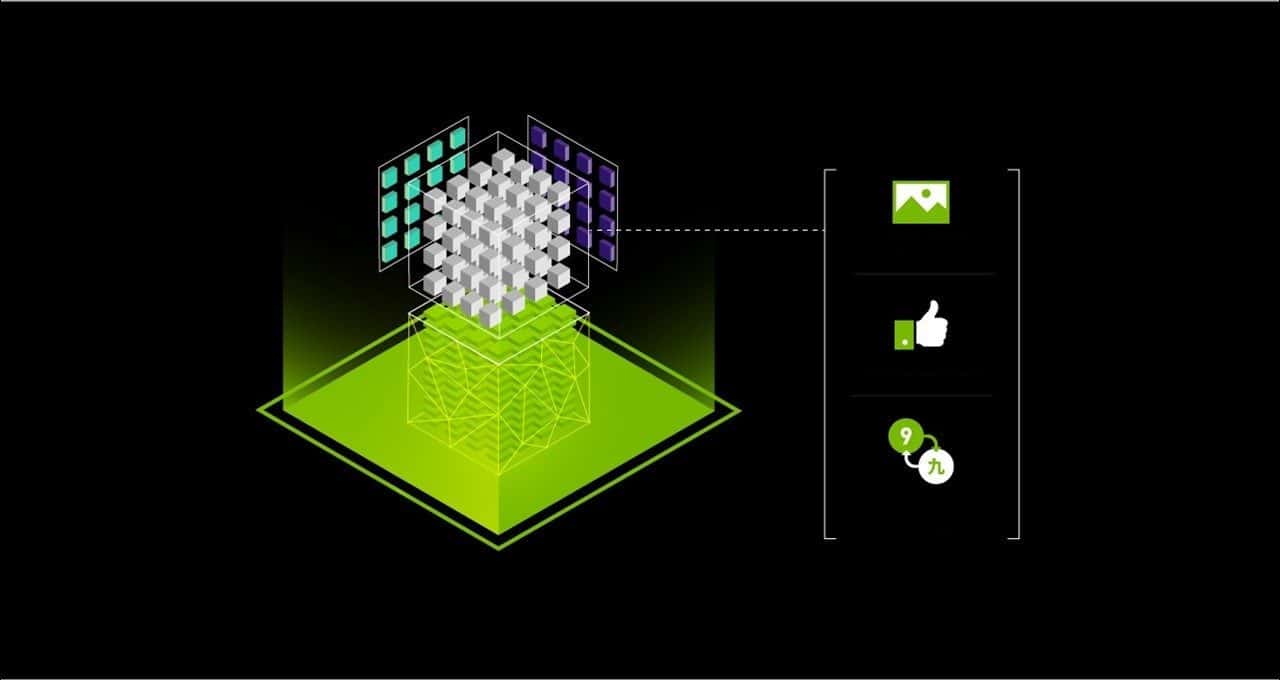

目前多數人工智慧推論作業都是在 CPU 上進行,但各類人工智慧模型開始紛紛採用 NVIDIA Tensor Core GPU。Tensor Core 是一項突破性創技術新,將 NVIDIA GPU 變成高效率又多功能的人工智慧處理器。Tensor Cores 能以高速進行多精度計算,對各類人工智慧模型提供最佳精度,且自動支援熱門的人工智慧框架。

這正是包括 Microsoft、Paypal、Pinterest、Snap 及 Twitter 在內,愈來愈多消費者網路公司開始採用 GPU 進行推論作業的原因。

將Tensor Core GPU 用於電腦視覺所創造出的驚人價值

最初採用 NVIDIA Volta 架構的 Tensor Core GPU,現已推出採用 NVIDIA Turing 架構的第二代產品。Tensor Cores 極佳的人工智慧運算表現,可以達到全範圍的精度,從有著 32-bit 累加的 16-bit 浮點運算,到有著 32-bit 累加的 8-bit,甚至是 4-bit 整數運算。

這些 GPU 是設計為加快執行人工智慧和推論作業的速度,使用 TensorFlow 和 PyTorch 框架中的 automatic mixed precision(自動混合精度)功能便能輕鬆啟用。開發人員只要在 TensorFlow 專案中加入兩行程式碼,就能將訓練速度加快三倍。

如下表所示,在比較相同數量的處理器時,NVIDIA T4 執行電腦視覺的速度更快、省電表現高出七倍,價格還更實惠。專為人工智慧訓練所設計的 NVIDIA V100 在執行推論作業時,速度較 CPU 快上兩倍,省電表現高出兩倍。

表一:在 ResNet-50 上的推論表現。

| 雙插槽

Intel Xeon 9282 |

NVIDIA V100

(Volta 架構) |

NVIDIA T4(Turing 架構) | |

| ResNet-50 Inference(圖片/秒) | 7,878 | 7,844 | 4,944 |

| 處理器數量 | 2 | 1 | 1 |

| 總處理器 TDP | 800 W | 350 W | 70 W |

| 能源使用效率(以 TDP 為測量基礎) | 10張圖片/秒/W | 22張圖片/秒/W | 71張圖片/秒/W |

| 每個處理器的效能(圖片/秒) | 3,939 | 7,844 | 4,944 |

| GPU 效能優勢 | 1.0(基線) | 2.0x | 1.3x |

| GPU 能源使用效率優勢 | 1.0(基線) | 2.3x | 7.2x |

資料來源:Intel Xeon 效能表現;NVIDIA GPU 效能表現

將Tensor Core GPU 用於瞭解自然語言所創造出的驚人價值

人工智慧領域呈現飛快的成長速度,人工智慧研究人員與資料科學家團隊不斷進行創新,以及建立高精度且極為複雜的人工智慧模型,進一步加快推動這個領域的發展。

四年多前,電腦視覺是 Microsoft 的人工智慧能運用 ResNet-50 這類模型,以超高精準度來執行的首批應用程式之一。而當前更先進的模型,則能執行更複雜的任務,像是用超高精準度來理解語言和語音內容。Google 去年以開放源碼型態開發出超級複雜的 BERT 人工智慧模型,如今能以絕佳精準度來理解散文內容和回答問題。

人工智慧模型的複雜度,端視其中的參數數量而定。人工智慧模型裡的參數,便是儲存模型已經學到之資料的變數。ResNet-50 有2500萬個參數,但 BERT 有3.4億個,是它的13倍。

在 BERT 這般先進的模型上,單一 NVIDIA T4 GPU 比起雙插槽 CPU 伺服器,在處理速度方面快上56倍,省電方面的表現更是高出240倍。

表2:在 BERT 上進行推論作業。工作負載量:使用BERT Large 資料組進行微調推論作業。

| 兩具 Intel Xeon

Gold 6240 |

NVIDIA T4

(Turing 架構) |

|

| BERT 推論表現,

問題-回答(句子/秒) |

2 | 118 |

| 處理器 TDP | 300 W(150 Wx2) | 70 W |

| 能源使用效率(以 TDP 為測量基礎) | 0.007句子/秒/W | 1.7句子/秒/W |

| GPU 效能優勢 | 1.0(基線) | 59x |

| GPU 能源使用效率優勢 | 1.0(基線) | 240x |

CPU 伺服器:雙插槽 Xeon Gold 6240@2.6GHz;384GB 系統 RAM;FP32 精度;使用Intel 的 TF Docker 容器 v.1.13.1。註:批次大小4的結果產生出最佳 CPU 分數。

GPU 結果:T4:雙插槽 Xeon Gold 6240@2.6GHz;384GB 系統 RAM;混合精度;CUDA 10.1.105;NCCL 2.4.3、cuDNN 7.5.0.56、cuBLAS 10.1.105;NVIDIA 驅動程式 418.67;在 TensorFlow 上使用自動混合精度與 XLA 編譯器;批次大小4、序列長度128,用於所有測試平台。

將Tensor Core GPU 用於推薦系統所創造出的驚人價值

推薦系統是人工智慧的另一項重點用途,用以在影片分享網站上推薦相關內容、在社群網站上推薦新聞,還有在電商網站上推薦商品。

神經協同過濾(Neural collaborative filtering,NCF)推薦系統,使用用戶與項目的先前互動情況來提供推薦內容。在作為 MLPerf 0.5 訓練基準測試部分內容的 NCF 模型上進行推論時,NVIDIA T4 的表現較 CPU 高出12倍,省電表現則是高出24倍。

表3:在 NCF 上進行推論。

| 單具 Intel Xeon

Gold 6140 |

NVIDIA T4

(Turing 架構) |

|

| 推薦推論生產能力(MovieLens)

(數千個樣本/秒) |

2,860 | 27,800 |

| 處理器 TDP | 150 W | 70 W |

| 能源使用效率(以 TDP 為測量基礎) | 19樣本/秒/W | 397樣本/秒/W |

| GPU 效能優勢 | 1.0(基線) | 10x |

| GPU 能源使用效率優勢 | 1.0(基線) | 20x |

CPU 伺服器:單插槽 Xeon Gold 6240@2.6GHz;384GB 系統 RAM;使用Intel Benchmark for NCF on TensorFlow 搭配 Intel 的 TF Docker 容器版本1.13.1;FP32 精度。註:CPU 測試使用單插槽 CPU 配置,它產生出較雙插槽 CPU 配置更佳的分數。

GPU結果:T4:單插槽 Xeon Gold 6140@2.3GHz;384GB 系統 RAM;CUDA 10.1.105;NCCL 2.4.3、cuDNN 7.5.0.56、cuBLAS 10.1.105;NVIDIA 驅動程式 418.40.04;在TensorFlow 上使用自動混合精度與 XLA 編譯器;批次大小:CPU 為2,048,T4 為1,048,576;精度:CPU 為 FP32,T4 為混合精度。

進行人工智慧訓練與推論的統一平台

在應用程式裡使用人工智慧模型是一個疊代過程,旨在不斷提高其性能表現。資料科學家團隊一直用新的資料和演算法來更新模型,以求提高精準性。開發人員再在應用程式內更新這些模型。

可以每月、每週甚至每天進行更新。建立一個用於人工智慧訓練和推論的平台,可以大幅簡化和加速在應用程式內部署及更新人工智慧的過程。

一如標準人工智慧測試基準 MLPerf 所展現出的結果,NVIDIA 的資料中心 GPU 運算平台在人工智慧訓練的表現方面,領先業界一大段。從上述數據可以得知,NVIDIA 平台展現出極為優秀的推論價值。隨著現代人工智慧日益變得複雜和進步,這個價值也隨之水漲船高。

為了推動人工智慧的快速發展,NVIDIA 與商業生態體系深入合作且不斷優化軟體,包括 TensorFlow、Pytorch 和 MxNet 等重要框架,加上 TensorRT 及 TensorRT Inference Server 等推論軟體。

NVIDIA 還會定期發布已預先完成訓練的人工智慧推論模型,以及使用你自己資料來訓練模型的模型腳本。用戶可以從 NVIDIA 的 GPU 加速軟體中心 NGC,用容器的方式免費下載和運行這些軟體。

徹底認識我們的綜合性人工智慧平台。

td{

border-top: 1px solid #ddd;

}