導盲犬十分適合協助視障者穿行這個世界,只不過要讓導盲犬大聲唸出標誌內容,或者告訴你錢包裡還剩多少錢,這可就有點傷腦筋了。

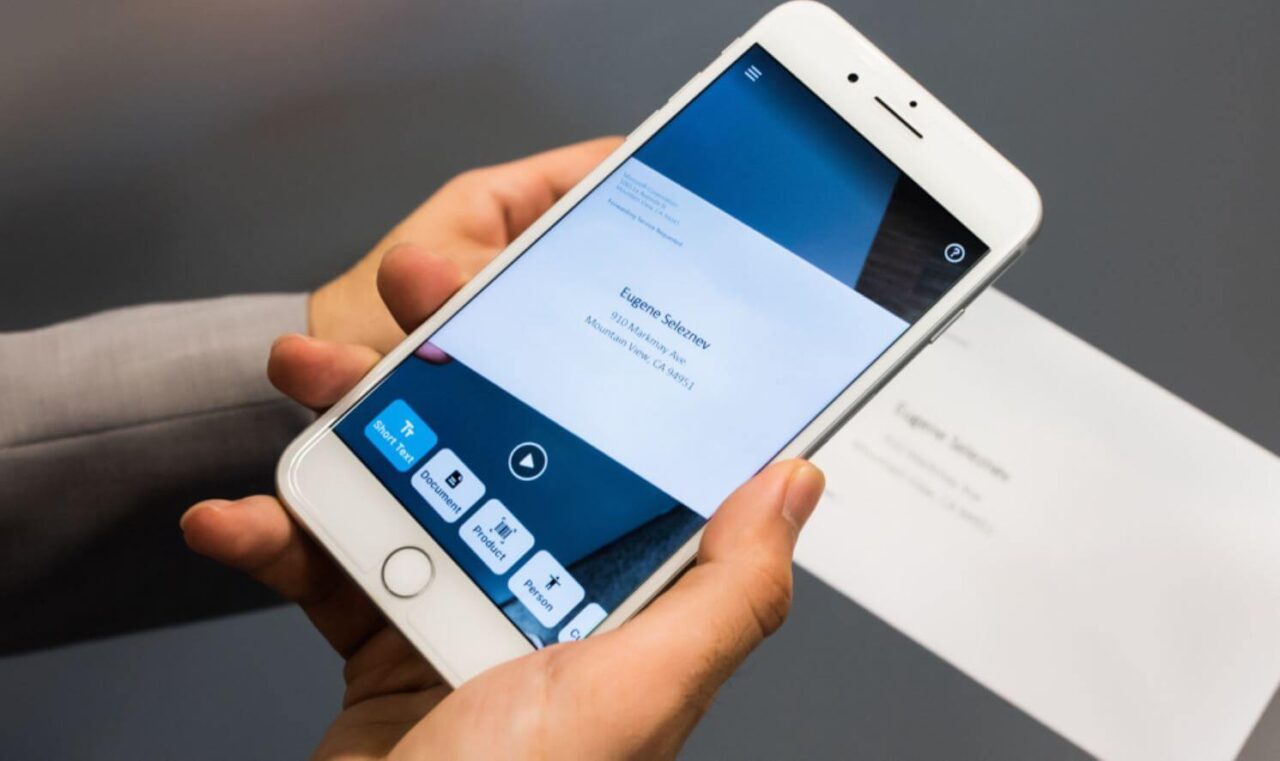

由 Microsoft AI & Research 開發出的「Seeing AI」這款 app,說不定能解開這個問題。它基本上會為視障者說出四周環境,讓他們能使用手中的智慧型手機辨識物體、顏色、紙鈔或文件的各種內容。

從去年推出這款 app 以來,下載量已達15萬次,使用量達500萬次,使用族群裡還包括了全球某些最出名的視障者。

「盲人歌手 Stevie Wonder 每天都會用到它,這超酷的。」Microsoft 資深資料科學家 Anirudh Koul 在上個月於聖荷西舉行的 GPU 技術大會上發表演講時,這麼對聽眾說。

Koul 跟他的同事在 GPU 技術大會的舞台上,實際演示這款強大的 app。Koul 拿出智慧型手機、啟動 app,並且將手機指向同事,app 讀出它看到「一名31歲、黑髮、戴眼鏡的男子,看起來一臉很高興的樣子。」

要是同事有出現在他的聯絡人名單裡,表現會更好,Seeing AI 會跟使用者的聯絡人名單進行整合,按照姓名來辨識朋友。

Koul 還分享了多個引人注目的例子,包括一名盲人教師開著 app,把手機朝著教室門口擺放,這樣孩子們就不會因為她看不見而偷溜進出教室;另一名使用者則是藉由 app 進行導航來通過颶風肆虐的地區,以避開掉落的電線和其它障礙物。

最早於2014年2月開始研發 Seeing AI 的目的,為建立一套卷積神經網路,以協助查找及辨識四周的物體,可是當時的延遲時間為十秒,速度過慢而無法幫助使用者迅速做出決定。

隔年 Microsoft 贊助了為期一周的黑客松(hackathon)活動,吸引了13,000名參賽者,再度嘗試將手機裝在使用者的頭上。

在嘗試使用智慧型眼鏡後,Koul 的團隊開始著手於研發 app 本身。他們使用 NVIDIA TITAN X GPU 進行本地端的神經網路訓練工作,更為吃重的升級則是交給運行 NVIDIA Tesla P100 GPU 的 Azure 雲實例。逐幀分析則是用以判斷發生每次訓練的位置。

調校人工智慧

訓練一事反映出 app 不得不辨識之影像的不確定性,像是在訓練 app 偵測金錢時,受訓練的神經網路必須接觸到骯髒和只有片面局部的貨幣照片,還有得放大貨幣照片極為細微的部分,以確定其特徵為何。

研究團隊徵求志工提供照片,得到各種結果,包括一隻貓在玩弄紙鈔的照片,另一張照片則是紙鈔卡在冰裡。

隨著模型接觸到這些不同照片,方能計算出辨識照片所需的最小參數。

Koul 的團隊調整了神經網路,傾向於對物體進行負面分類或者不進行分類,而非猜測或是將五美元的紙鈔當成十美元的紙鈔,這顯然會給視障者造成不便。

人工智慧的最終特點之一就是為視障者帶來福音,唯有愈多人使用這款 app 時才會變得更精良。