對於未受過訓練的人來說,它們是一堆各種顏色的邊框、方塊和數字,而對於訓練有素的觀察者而言,它們是從魚眼鏡頭、光達和其它感應器讀取到的數據,而自動駕駛車就穿梭在這個複雜環境的各種細節之間。

你在今年拉斯維加斯舉行的美國消費電子展,會見到無數各大車廠和研究人員所提出的展演內容,他們從新一代自動駕駛系統的觀點展示車輛未來發展走勢。

我們透過全球最強大的車用人工智慧車用引擎 NVIDIA DRIVE PX 2,帶領車廠及研究機構進行這項研發工作。DriveWorks 軟體加上 DRIVE PX 2,讓車廠的研發人員能將深度學習的實力用在新一代的自動駕駛車上。

這些新系統所展現出的技術令人驚嘆不已 – 每秒達到驚人的24 兆次深度學習運算速度,還是得說明一下它們所具備的本事。

以下簡短介紹你在觀看自動駕駛展演內容時,會看到和不會看到的內容。

你會看到的內容

你將在會場裡見到兩類辨識能力:

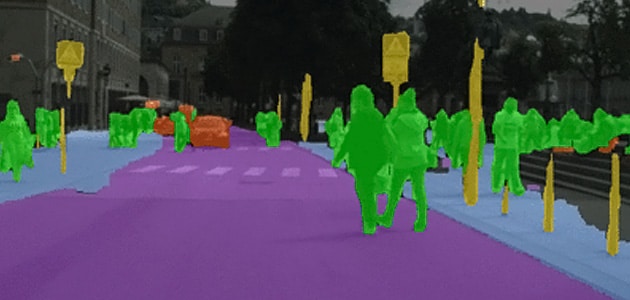

語義分割 — 這項能力可標示出屬於特定物件類別的畫素(構成電腦影像的小點)。在下圖裡可以見到道路是藍色的,人是橘色的,車輛是紅色的,要是電腦區別影像內物體的精細程度能達到這般水準,我們就有信心自動駕駛系統能夠安全地進行導航。

物件偵測 — 這項能力可以方塊標示出物體位置,在多支影片裡展示我們同時偵測多個物件類別的實力。在下例裡,我們設計了一款能辨識人和車輛的偵測器,透過邊框會比分割法更易於表達物體位置。

你不會看到的內容

在眾多展示自動駕駛系統所見到之路況畫面的內容時,你會在螢幕上注意到語義分割和物體偵測這兩項技術。

但是你不會看到在推動這一切的重要幕後推手:深度學習技術。深度學習技術讓我們做到人們無法達成的事情,開發能辨識出路上每個物件類別的軟體並不具有實用性,路上有太多東西了。

這套解決方案就是教導機器自我學習。深度學習技術讓我們能設定一個困難的目標,要是使用對的演算法規劃出正確的方程式,神經網路就能找出方法來解決複雜事物。

我們利用 NVIDIA GPU 強大的運算能力來訓練這些神經網路,GPU 能一次以平行方式處理很多工作,最適合用於深度學習。

我們將以日前發表的 GoogLeNet 及 VGG 等先進深度學習網路為基礎,使用單擊偵測和分割架構,而單擊代表網路會取得完整影像,並且吐出偵測或分割畫素標示內容。

此舉使得車廠能使用真實駕駛情境影片,快速訓練系統辨識各種車況裡的物件,丟入深度學習系統的資料愈多,系統就會變得更聰明;還能透過 KITTI 基準套件等獨立研究單位的實際影像辨識基準,對辨識結果進行同儕比較。

如何判斷眼中的內容

下次在觀看展演內容時,請提出三個問題。如何訓練這些系統理解從未見過的情況?是即時運作的嗎?這些結果跟電腦科學家用以衡量電腦視覺系統準確性的基準相比,它們的表現又是如何?