【2025年3月18日,美國聖荷西訊】NVIDIA 今日發表開源推論軟體 NVIDIA Dynamo,用於在人工智慧(AI)工廠中以最低成本和最高效率加速與擴展 AI 推理模型。

在大量 GPU 組合中有效率地統籌和協調 AI 推論請求,對於確保AI 工廠用最低成本運行以創造最高的詞元收益來說至關重要。

隨著 AI 推理成為主流,每個 AI 模型每次提示都會產生數以萬計用於「思考」的詞元。在不斷降低推論成本的同時提升推論效能,可加速推動服務供應商的成長,並增加營收機會。

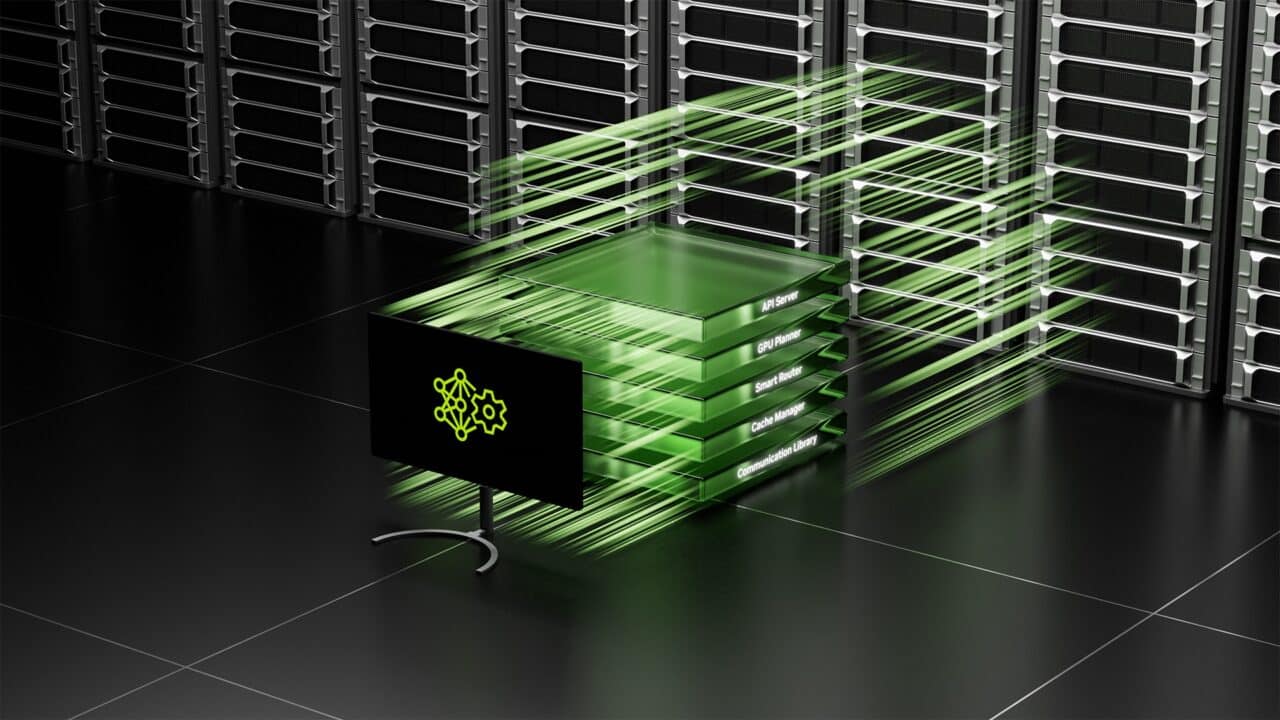

NVIDIA Dynamo,是 NVIDIA Triton Inference Server™ 的後繼者,是全新的 AI 推論服務軟體,專為 AI 工廠部署推理 AI 模型,以創造最高的詞元收益。它可以在數千個 GPU 之間協調並加速推論通訊,並使用分散式服務將大型語言模型的處理與產生階段分開在不同 GPU 上。這可以讓每個階段針對其特定需求各自進行最佳化,同時確保 GPU 資源的利用率最大化。

NVIDIA 創辦人暨執行長黃仁勳表示:「全球各產業都在訓練 AI 模型以不同方式進行思考與學習,讓模型隨著時間的推移變得更加複雜。為了實現客製化推理 AI 的未來,NVIDIA Dynamo 有助於為這些模型提供規模化服務,推動整個 AI 工廠節省成本和提高效率。」

在使用相同數量的 GPU 的情況下,Dynamo 可使運行 Llama 模型的 AI 工廠在當前 NVIDIA Hopper™ 平台上的效能與營收提升至兩倍。在 GB200 NVL72 機架的大型叢集上運行 DeepSeek-R1 模型時,NVIDIA Dynamo 的智慧推論最佳化功能也將每個 GPU 產生的詞元數量提高 30 倍以上。

為達到這些推論效能的提升,NVIDIA Dynamo 整合多項功能,使其能夠提高輸送量與降低成本。它可以動態新增、移除和重新分配 GPU,以因應不斷變動的請求量與類型,並在大型叢集裡精確定位特定的 GPU,以盡量減少回應運算與路由查詢。它還可以將推論資料卸載到更實惠的記憶體與儲存裝置,並在需要時快速取得,將推論成本降至最低。

NVIDIA Dynamo完全開源並支援 PyTorch、SGLang、NVIDIA TensorRT™-LLM和 vLLM,使企業、新創公司和研究人員能夠開發和最佳化 AI 模型的部署方式,實現分散式推論。它將讓使用者加速採用 AI 推論,包括 AWS、Cohere、CoreWeave、戴爾科技集團、Fireworks、Google Cloud、Lambda、Meta、Microsoft Azure、Nebius、NetApp、OCI、Perplexity、Together AI 和 VAST等。

大幅提升推論能力

NVIDIA Dynamo 的運作方式,是將推論系統從先前請求中儲存在記憶體裡的知識(亦稱為 KV 快取),映射到數千個 GPU 上。它接著將新的推論請求轉移到知識相符程度最高的 GPU,避免昂貴的重新運算,並騰出 GPU 來回應新傳入的請求。

Perplexity AI 技術長 Denis Yarats 表示:「為了處理每個月上億次的請求,我們必須仰賴 NVIDIA GPU 與推論軟體來提供我們的業務與使用者所要求的效能、可靠性及規模。我們期待利用 Dynamo 強化的分散式服務能力,驅動更高的推論服務效率,滿足新型 AI 推理模型的運算需求。」

代理型 AI

AI 供應商 Cohere 正計劃使用 NVIDIA Dynamo 在其 Command 系列模型中提供代理型 AI 功能。

Cohere 工程部門資深副總裁 Saurabh Baji 表示:「擴展進階的 AI 模型需要精密的多 GPU 調度、完美協調與低延遲的通訊函式庫,才能在記憶體與儲存空間之間無縫傳輸推理語境。我們期望 NVIDIA Dynamo 能協助我們為企業客戶提供極佳的使用者體驗。」

分散式服務

NVIDIA Dynamo 推論平台同樣支援分散式服務,這項服務將大型語言模型的不同運算階段,包括建立對使用者查詢的理解,然後產生最佳回應等,指派給不同的 GPU,這種方法非常適合推理模型,例如新的 NVIDIA Llama Nemotron 模型系列,它使用先進的推論技術來改善上下文理解和回應生成。分散式服務可以讓每個階段進行微調,並獨立提供資源,從而提高輸送量,同時為使用者提供更快速的回應。

AI 加速雲端服務業者 Together AI 希望將其專屬的 Together Inference Engine 與 NVIDIA Dynamo 整合,以實現推論工作負載在 GPU 節點間的無縫擴充。這也使得 Together AI 可以動態解決模型管道各階段的流量瓶頸。

Together AI 技術長張策表示:「以符合成本效益的方式擴充推理模型需要新的先進推論技術,包括分散式服務和情境感知路由。Together AI 使用我們專屬的推論引擎提供領先業界的表現。NVIDIA Dynamo 的開放性和模組化功能讓我們能夠把將其元件完美插入我們的引擎,在最佳化資源利用率的同時提供更多的服務請求,使我們的加速運算投資得以發揮最大效用。我們很高興能夠利用這個平台的突破性功能,以經濟高效的方式將開源推理模型帶給我們的用戶。」

解密 NVIDIA Dynamo

NVIDIA Dynamo 內含四大創新技術,可降低推論服務成本與改善使用者體驗:

- GPU 規劃器(GPU Planner):規劃引擎可動態增加或移除 GPU,以因應使用者需求的變動,避免 GPU 供應過多或不足。

- 智慧路由器(Smart Router):可感知大型語言模型的路由器,可以在大型 GPU 組合間引導請求,將重複或重疊請求且所費不貲的 GPU 重新運算成本降至最低,進而騰出 GPU 來回應新傳入的請求。

- 低延遲通訊函式庫(Low-Latency Communication Library):經過推論最佳化的函式庫能支援最先進的 GPU 對 GPU 通訊,並將不同裝置間交換資料的複雜性抽象化,加快資料傳輸。

- 記憶體管理器(Memory Manager):這個引擎可在不影響使用者體驗的情況下,智慧地將推論資料卸載或重新載入成本較低的記憶體與儲存裝置。

NVIDIA Dynamo將在 NVIDIA NIM 微服務中提供,將在未來獲得 NVIDIA AI Enterprise 軟體平台的支援,提供生產級的安全性、支援與穩定性。

歡迎觀看 NVIDIA GTC 主題演講、閱讀此Dynamo 部落格以瞭解更多資訊,並且報名參加 NVIDIA 與業界領導者在 GTC 大會的各項精彩會議,GTC 大會將從即日起舉辦至 3 月 21 日。

關於NVIDIA(輝達)

NVIDIA(輝達)為加速運算領域的先驅。

NVIDIA前瞻性聲明

本新聞稿根據目前預期所做出的前瞻性聲明,包含但不限於:NVIDIA的產品和技術;第三方使用或採用 NVIDIA 產品、技術和平台及其優點和影響;全球各產業都在訓練 AI 模型以不同方式進行思考與學習,讓模型隨著時間的推移變得更加複雜。為了實現客製化推理 AI 的未來,NVIDIA Dynamo 有助於為這些模型提供規模化服務,推動整個 AI 工廠節省成本和提高效率等。這些前瞻性聲明包含可能導致實質結果與預期不符之風險與不確定因素。多項重要因素可能導致實際結果與前瞻性聲明所示之結果出現重大差異,所及範圍有全球經濟情況;NVIDIA的產品借重第三方協力廠商之製造、組合、封裝和測試;技術發展和市場競爭之影響;發展新產品與技術或強化現有的產品及技術;NVIDIA或合作廠商的產品的市場接受度;設計、製造或軟體缺陷;消費者偏好或需求之改變;業界標準和介面之改變;整合到系統後無法預期的NVIDIA產品或效能降低之技術缺失,以及NVIDIA定期提交給美國證券交易委員會(SEC)報告中的其他詳細因素,包含但不限於Form10-K的年度報告和Form10-Q的季度報告。NVIDIA 在公司官方網站上免費提供定期提交給SEC的報告之副本。這些前瞻性聲明不保證未來的效能,只陳述目前的狀態。除非法律規定,否則NVIDIA沒有意願或義務因為新資訊、未來事件或其他理由而更新或修改任何前瞻性聲明。

©本文為NVIDIA 公司 2025版權所有,並保留所有權利。NVIDIA、NVIDIA 標誌、NVIDIA Hopper、NVIDIA NIM、NVIDIA Triton 推論伺服器和TensorRT是NVIDIA 公司在美國及其他地區的商標及(或)註冊商標。所有其他公司及產品名稱乃為所屬個別公司之商標。功能、訂價、出貨時程和規格之變更不會另行通知。