國際學習表徵會議(International Conference on Learning Representations)是一個十分拗口的名稱,但對於想要維持在深度學習領域發展尖端的研究人員來說,這是一個值得前往的地方。

這場會議名稱的縮寫「ICLR」更廣為人知,4月30日至5月3日來自全球頂尖人工智慧研究實驗室的專家將齊聚溫哥華。瑞士人工智慧實驗室(IDSIA)、紐約大學與東京大學這三個 NVIDIA 人工智慧實驗室(NVAIL)合作夥伴,將出席今年的大會分享他們的研究成果。

IDSIA 的研究團隊旨於讓機器人能像人類一樣自然,對實體環境擁有相同的理解能力。東京大學的團隊將介紹其增進聲音辨別能力的創新方法。紐約大學與巴斯克大學的研究人員將說明他們如何提高機器翻譯語言的能力。

我們的 NVAIL 計畫提供支持學生、獲得 NVIDIA 研究員及工程師的協助,還有取得業界最先進的 GPU 運算能力,讓這些機構和其他人工智慧先驅單位能保持在領先地位。

風水輪流轉

人類天生就明白實體世界的反應。我們可以穿越過從未去過的房間。要是鞋子掉了,我們也知道它會掉在地板上。我們很清楚知道人體無法穿過牆壁。就算嬰兒也對實體環境有一些基本的認識。

IDSIA 的博士生 Sjoerd van Steenkiste 說機器就沒有那麼容易了。現在訓練一套深度學習模型來理解像是「風水輪流轉」的事情,需要大量資料和人力來標記它。

他跟來自 IDSIA 及加州大學柏克萊分校的研究小組,努力縮減對大量資料和人員互動的需求來簡化這個過程。

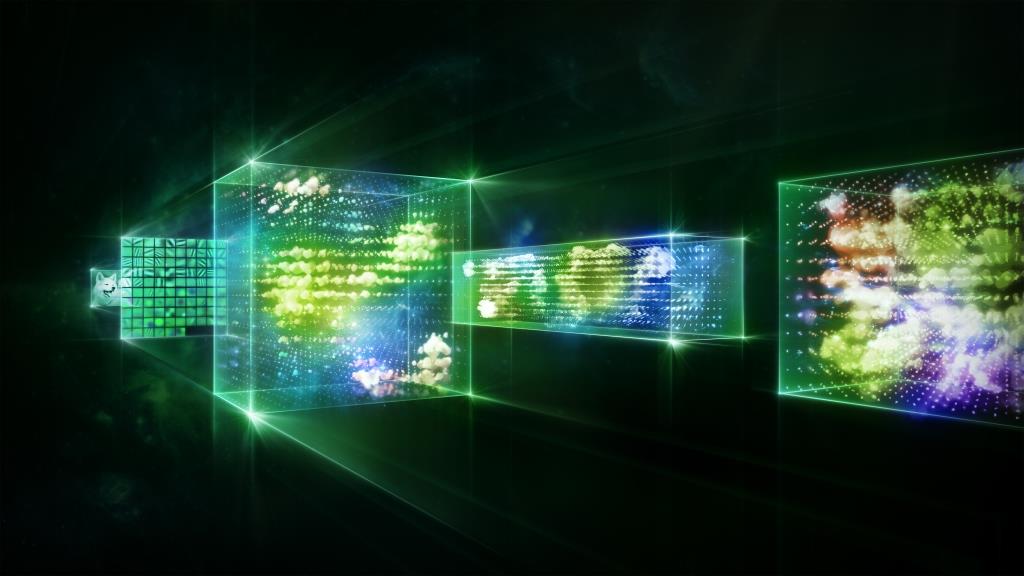

研究人員在這篇於 ICLR 發表的報告裡,描述了他們如何在沒有人工輸入資料的情況下訓練神經網路,這個過程稱為非監督式學習。他們使用 DGX-1 人工智慧超級電腦來訓練深度學習模型,以區分場景裡的個別物體及預測動作結果。

van Steenkiste 說這項研究最終可以更輕鬆地訓練機器人及其它機器,與它們所處的環境進行互動。

混合聲音

有些東西混合在一起會變得美好。巧克力搭上花生醬,簡直是天堂般的美味;將金屬混合在一起,會讓它們變得更更堅硬;而同時種植兩種作物則能擴大產量。

Yuji Tokozume 把同樣的想法用於深度學習上。這名博士生與東京大學另外兩名研究員致力於利用他們所謂「類別間的聲音」(即兩種聲音混合在一起)來訓練深度學習模式,以提升聲音辨識能力。這項在 Tesla P100 GPU 加速器上進行訓練的模型,可以辨識兩種聲音和判斷兩者間的比例。

這群研究員在他們於 ICLR 發表的報告裡,表示類別間的學習這項技術,不僅較現有技術擁有更高的準確性,而且在標準資料集 ESC-50 的環境錄音內容方面超越了人類的表現。該團隊已經運用相同的方法來改善人工智慧辨識影像的表現。

請觀看日前在矽谷舉行之 GPU 技術大會所進行的聲音辨識類別間學習演講內容,以更深入瞭解相關資訊。

迷失在語言翻譯裡

人工智慧在自動語言翻譯方面的成就,對於巴斯克語、奧羅莫語與奇楚瓦語等罕見的語言來說並沒有發揮太大的作用。原因在於訓練深度學習模型通常需要使用大量資料,而這些罕見語言則是以人工方式將大量文字翻譯成其它語言。

中文、英文及西班牙文等廣泛使用的語言,有著豐富的資料,可以直接將中文翻譯成英文,或將西班牙文翻譯成中文。紐約大學與巴斯克大學的研究人員打算將這種能力用於使用族群稀少的罕見語言上。

巴斯克大學博士生 Mikel Artetxe 表示,目前像是巴斯克語這樣的語言(估計約有70萬人使用,大部分在跨越西班牙與法國的邊境地區)必須先譯成英語(或另一種主要語言),然後才能再譯成其它語言。

在非洲之角有超過三千萬人使用的奧羅莫語,或是南美洲有多達一千一百萬人使用的奇楚瓦語也是如此。

研究團隊使用我們的 TITAN Xp GPU 來訓練神經網路進行翻譯,未使用任何人工翻譯的訓練資料,而是依賴於兩種語言的獨立文字。研究人員在他們於 ICLR 發表的報告裡表示加入少量平行資料時,準確度會有所提高,但仍遠低於人類翻譯的準確度。

「我們的目標是能以更好的結果翻譯更多種類的語言。」Artexe 說。