為推動下一波人工智慧 (AI) 資料中心的發展,NVIDIA (輝達) 今天宣布推出採用 NVIDIA Hopper™ 架構的新一代加速運算平台,效能較上一代平台呈指數級成長。這個以美國電腦科學家先驅 Grace Hopper 命名的全新架構,將接替兩年前推出的 NVIDIA Ampere 架構。

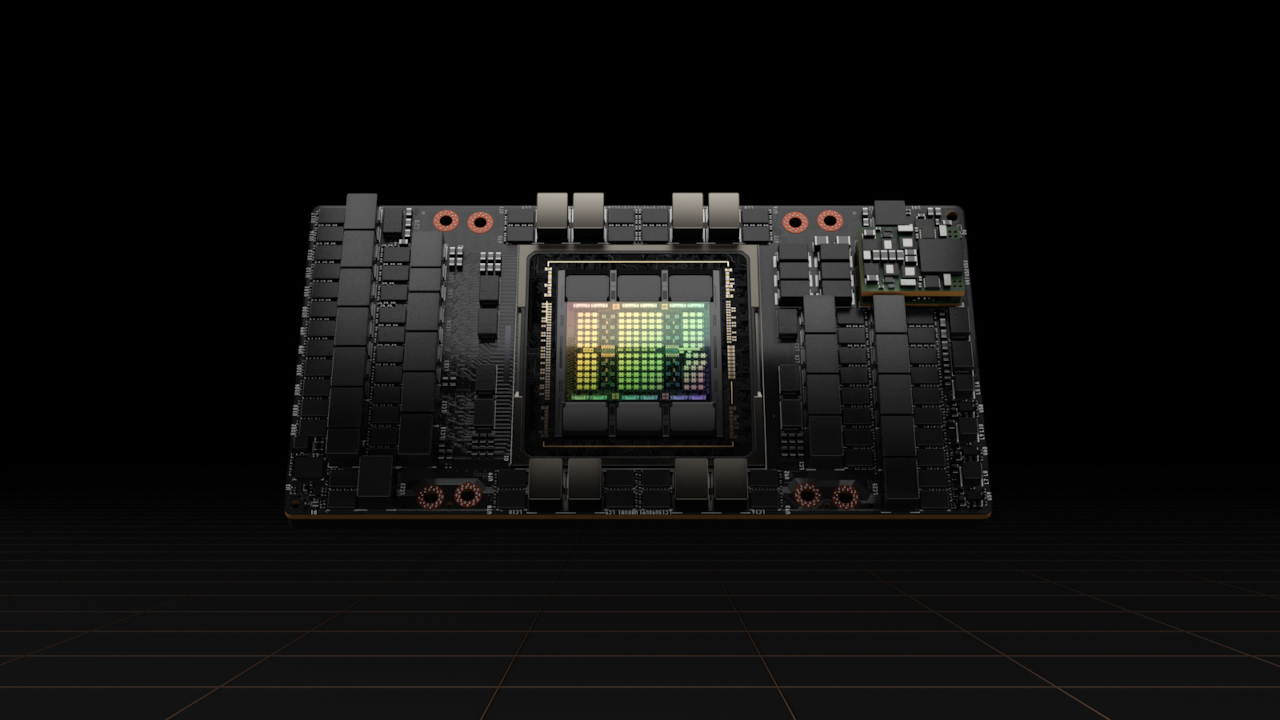

NVIDIA 亦宣佈推出首款採用 Hopper 架構的 GPU 產品 NVIDIA H100,這款 GPU 封裝了 800 億個電晶體,是全球最大且效能最強大的加速器,具突破性的功能,例如革命性的 Transformer Engine 及具高度擴展性的 NVLink® 互連技術,可用於推動極大規模的 AI 語言模型、深度推薦系統、基因組學和複雜的數位孿生等領域的發展。

NVIDIA 創辦人暨執行長黃仁勳表示:「資料中心將成為 AI 工廠,用來處理海量資料並從中提煉出寶貴的智慧。NVIDIA H100 是全球 AI 基礎設施的引擎,讓企業得以加速推動各項 AI 業務的進展。」

H100 的突破性技術

NVIDIA H100 GPU 為加速大規模 AI 及高效能運算樹立了新標準,並帶來六項突破性創新:

- 全球最先進的晶片:H100 擁有 800 億個電晶體,採用台積電 4N 製程、專為滿足 NVIDIA 加速運算需求而設計,在加速 AI、高效能運算、記憶體頻寬、互連和通訊方面具有重大進展,包括每秒近 5TB 的外部連接速度。H100 是首款支援 PCIe Gen5 及首款使用 HBM3 的 GPU 產品,提供每秒 3TB 的記憶體頻寬。20 個 H100 GPU 便足以支撐全世界的網路流量,讓客戶得以運行先進的推薦系統和大型語言模型,即時使用各項資料進行推論。

- 全新 Transformer Engine:Transformer 已是自然語言處理的首選標準模型,是史上最重要的深度學習模型之一。相較於前一代產品,H100 加速器的 Transformer Engine 能夠將這些網路的速度提高六倍,又不失其精度。

- 第二代安全多執行個體 GPU:多執行個體 GPU (Multi-Instance GPU;MIG) 技術可以將一個 GPU 分割成七個較小、完全隔離的執行個體以處理各類工作。Hopper 架構在雲端環境裡為每個 GPU 執行個體提供安全的多租戶配置,將 MIG 的能力較前一代擴大高達七倍。

- 機密運算:H100 是全球首款具有機密運算能力的加速器,可以在處理 AI 模型和客戶資料時加以保護。對於醫療照護和金融服務等對隱私極為敏感的產業,在進行聯邦學習時同樣能運用機密運算,在共享的雲端基礎設施上也同樣可行。

- 第四代 NVIDIA NVLink:為加快最大型 AI 模型的運作速度,以 NVLink 搭配全新的外部 NVLink 交換器,將 NVLink 當成伺服器以外的垂直擴展網路,相較於使用 NVIDIA HDR Quantum InfiniBand 的前一代產品,能以超過九倍的頻寬連接多達 256 個 H100 GPU。

- DPX 指令:與使用 CPU 相比,全新 DPX 指令將用於眾多演算法 (包括路線最佳化及基因組學) 的動態規畫執行速度加快高達 40 倍;而與使用前一代的 GPU 相比,速度加快了七倍。這包括為動態倉庫環境中的自主機器人車隊尋找最佳路線的 Floyd-Warshall 演算法,以及用於 DNA 和蛋白質分類及折疊的序列比對 Smith-Waterman 演算法。

H100 的多項技術創新擴大了 NVIDIA 在 AI 推論和訓練的領先地位,使 NVIDIA 能夠利用巨大的 AI 模型做到即時和沉浸式應用。H100 讓聊天機器人可以使用全球最強大的單體 transformer 語言模型 Megatron 530B,其傳輸量超過前一代產品達 30 倍,同時滿足即時對話式 AI 所需的次秒級延遲。H100 同時讓研究人員和開發人員能夠訓練像是 Mixture of Experts 這類大規模模型,包含 3,950 億個參數,能將速度提高達九倍,將訓練時間從過去所需的數週減少到數日便能完成。

業界廣泛採用 NVIDIA H100

NVIDIA H100 可以部署在各類型的資料中心內,包括企業內部、雲端、混合雲和邊緣。預計今年稍晚透過全球各大雲端服務供應商及電腦製造商供貨,也可以直接向 NVIDIA 購買。

NVIDIA 第四代 DGX™ 系統 DGX H100 搭載八個 H100 GPU,可在全新 FP8 精度下提供 32 petaflops 的 AI 運算表現,這個規模足以滿足大型語言模型、推薦系統、醫療研究及氣候科學的大規模運算需求。

透過第四代 NVLink 技術連接 DGX H100 系統中的每個 GPU,能提供每秒 900GB 的連接速度,高出前一代產品 1.5 倍。NVSwitch™ 技術讓八個 H100 GPU 能透過 NVLink 連接。一台外部 NVLink 交換器可以連接新一代 NVIDIA DGX SuperPOD™ 超級電腦中多達 32 個 DGX H100 節點。

Hopper 已經獲得各大雲端服務供應商的支持,包括阿里雲、Amazon Web Services (AWS)、百度智能雲、Google Cloud、Microsoft Azure、Oracle Cloud 和騰訊雲,這些業者計畫將提供基於 H100 的執行個體。

全球一級系統製造商預計將推出多款搭載 H100 加速器的伺服器產品,包括源訊 (Atos)、BOXX Technologies、思科 (Cisco)、戴爾科技 (Dell Technologies)、富士通 (Fujitsu)、技嘉 (GIGABYTE)、新華三 (New H3C Information Technologies)、慧與科技 (Hewlett Packard Enterprise)、浪潮 (Inspur Electronic Information)、聯想 (Lenovo)、Nettrix 與美超微 (Supermicro)。

各種規格的 NVIDIA H100

H100 將有 SXM 和 PCIe 兩種規格,以滿足各種伺服器的設計要求。同時也將推出一款融合加速器,將 H100 GPU 搭配 NVIDIA ConnectX®-7 400Gb/s InfiniBand 及 Ethernet SmartNIC。

H100 SXM 規格將用於 HGX™ H100 伺服器主機板上,提供四路和八路配置,供企業在一台伺服器和多台伺服器上的應用程式擴大到多個 GPU 上。搭載 HGX H100 的伺服器為 AI 訓練和推論、資料分析和高效能運算應用程式提供最佳運算表現。

H100 PCIe 規格使用 NVLink 來連接兩個 GPU,提供較 PCIe 5.0 還要高出七倍的頻寬,為在主流企業伺服器上運行的應用程式提供出色效能。PCIe 的規格尺寸讓此產品能夠輕鬆地被納入現有的資料中心基礎設施中。

全新的融合加速器 H100 CNX 則是將 H100 搭配 ConnectX-7 SmartNIC,為企業資料中心的多節點 AI 訓練,以及邊緣的 5G 訊號處理等 I/O 密集型應用程式提供突破性的效能。

採用 NVIDIA Hopper 架構的 GPU 還能搭配 NVIDIA Grace™ CPU,後者具備超高速 NVLink-C2C 互連技術,與 PCIe 5.0 相比,CPU 與 GPU 之間的資料傳輸速度提高七倍以上。這樣的組合誕生出 Grace Hopper 超級晶片,用於巨大規模高效能運算及 AI 應用程式的整合模組。

NVIDIA 軟體支援

NVIDIA 提供強大的軟體工具來支援 H100 GPU,開發人員與企業便能建立及加速 AI 與高效能運算各類應用程式,包括針對語音、推薦系統和超大規模推論等作業負載所推出的 NVIDIA AI 軟體套件重大更新。

NVIDIA 還發布了超過 60 項 CUDA-X™ 函式庫、工具和技術更新,以加快量子運算、6G 網路研究、網路安全、基因組學和藥物開發等方面的進展。

供貨時程

NVIDIA H100 將於第三季開始供貨。

敬請觀看黃仁勳先生的 GTC 2022 主題演講,獲得更多關於 NVIDIA Hopper 及 H100 的資訊。免費報名 GTC 2022 大會,參加由 NVIDIA 及業界領導者主講的議程。

掌握 NVIDIA 最新動態

請訂閱 NVIDIA 官方部落格或追蹤 Facebook、Twitter、LinkedIn 與 Instagram。瀏覽 NVIDIA 相關影片及圖片,請至 YouTube 或 Flickr。

關於 NVIDIA (輝達)

NVIDIA (輝達) 自 1999 年發明 GPU 起便成功促進 PC 電競市場的成長,並重新定義現代電腦繪圖、高效能運算與人工智慧。NVIDIA 在加速運算和人工智慧領域的開創性成就,正重塑多個市場規模高達數兆美元的產業,如交通運輸、健康醫療和製造業,亦同時促進許多其他產業的成長。欲瞭解更多資訊,請瀏覽 https://blogs.nvidia.com.tw。

新聞聯絡人

| NVIDIA 亞太公關總監 杜佳祐 電話:(02)6605-5856 傳真:(02)8751-1809 E-mail: Melody Tu |

世紀奧美公關顧問 蔡宜真/黃晨瑀/詹淑君 電話:(02) 7745-1688 分機 135/128/133 傳真:(02) 7743-9199 行動電話: 0970504933/0931309553/ 0975251507 E-mail: Salin Tsai/ Bonnie Huang/ Shirley Chan |

本新聞稿可能包含 NVIDIA 根據目前預期所做出的前瞻性聲明:NVIDIA Hopper 架構、NVIDIA H100 GPU 與 DGX H100 的優點、影響、規格、效能和供貨時程;資料中心成為 AI 工廠;NVIDIA H100 為全球資料中心提供新一代引擎,讓企業得以運用AI進行業務轉型;客戶能夠將機密運算用於聯邦學習;NVIDIA H100 可以部署在各類型資料中心;對 NVIDIA H100 的軟體支援。多項重要因素可能導致實際結果與前瞻性聲明所示之結果出現重大差異,所及範圍有全球經濟情況;我們的產品借重第三方協力廠商之製造、組合、封裝和測試之部分;技術發展和市場競爭之影響;新產品或技術之發展或我們現有產品與技術之提升;市場接受我們的產品或合作夥伴產品的程度;設計、製造或軟體的缺失;消費者偏好或需求之改變;業界標準和介面之改變;整合到系統後無法預期的產品或效能降低之技術缺失;以及我們定期提交給美國證券交易委員會 (SEC) 以 Form 10-Q 報告附本為基礎的Form 10-K財務季度等其他詳細因素。NVIDIA在公司官方網站上免費提供定期提交給SEC的報告之副本。這些前瞻性聲明不保證未來的效能,只陳述目前的狀態,除非法律規定,否則 NVIDIA 沒有意願或義務更新或修改任何前瞻性聲明。

©本文為NVIDIA公司 2022 版權所有,並保留所有權利。NVIDIA、NVIDIA 標誌、NVIDIA DRIVE、DRIVE Orin、NVIDIA DGX、NVIDIA DRIVE Hyperion 和 NVIDIA Omniverse 皆為 NVIDIA Corporation 在美國和其他國家/地區的商標和/或註冊商標。其他公司和產品名稱可能為與之相關的各自公司之商標。功能、價格、供貨情況和規格如有變更,恕不另行通知。