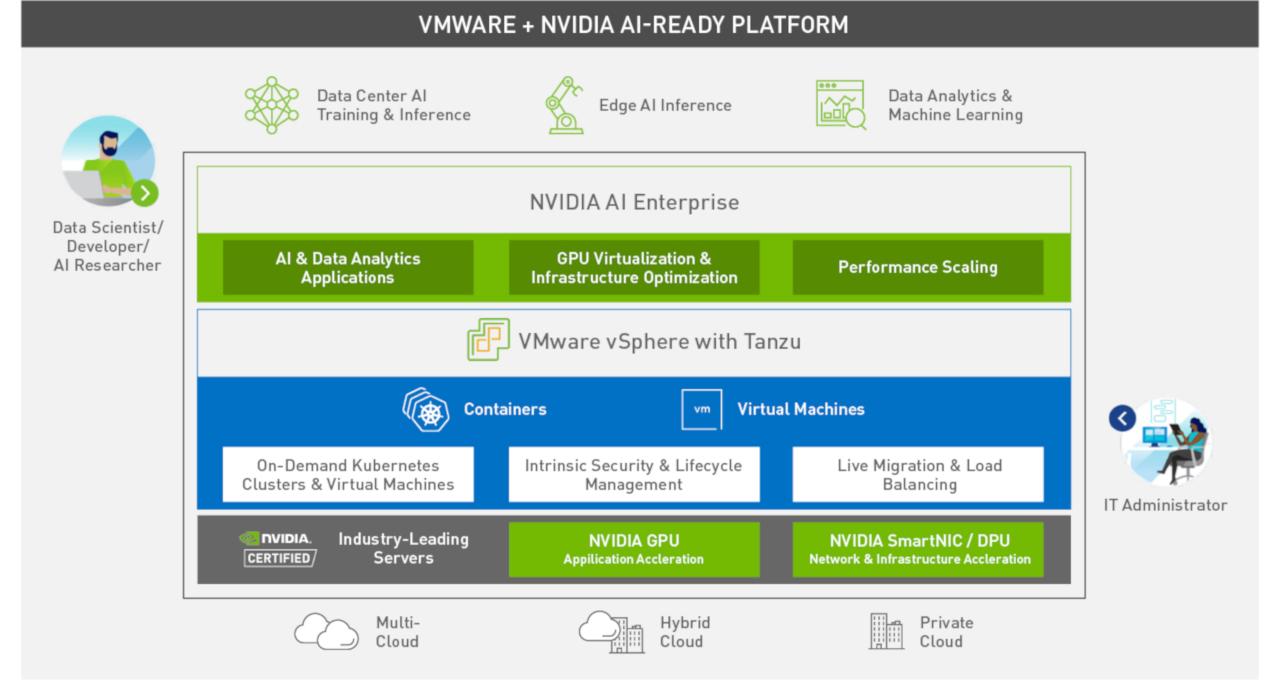

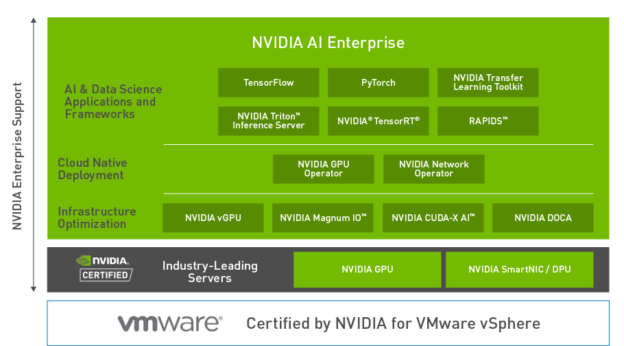

NVIDIA AI Enterprise 是 AI 軟體套件,經認證可以在搭配 NVIDIA-Certified 量產伺服器的 VMware vSphere 7 Update 2 上執行。其包含來自 NVIDIA 的關鍵賦能技術和軟體,可以迅速部署、管理和擴充在 VMware vSphere 上執行的虛擬化資料中心 AI 工作負載。 NVIDIA AI Enterprise 套件也可以協助 IT 管理員、資料科學家和 AI 研究人員縮短部署時間及確保可靠效能,以便能快速執行針對 GPU 加速,最佳化的 NVIDIA AI 應用程式和函式庫。

NVIDIA AI Enterprise 套件是由 NVIDIA 授權和支援。 NVIDIA 與 VMware 於 2020 年 9 月,在 VMworld 上聯合發表之後,持續在改進聯合產品之間的整合。 NVIDIA 與 VMware 致力於持續合作,將 VMware vSphere 與 NVIDIA AI Enterprise 套件緊密結合。本文章是探討 VMware vSphere 7 Update 2 版本和新的 NVIDIA AI Enterprise 軟體套件導入的新功能。

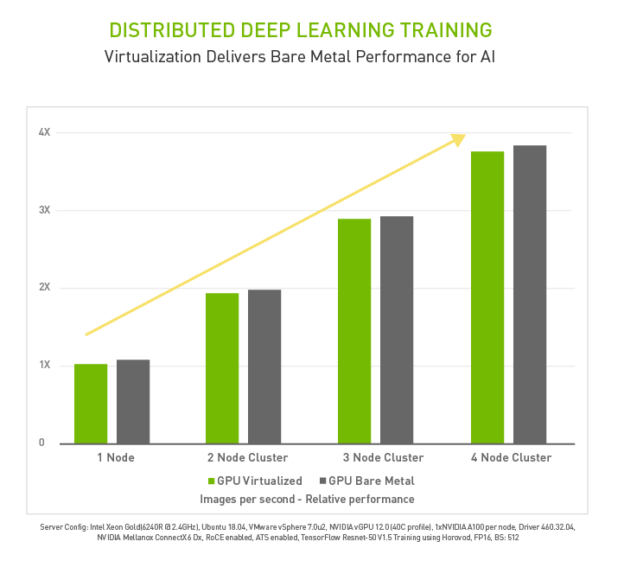

針對 NVIDIA 虛擬化 GPU (vGPU),將 NVIDIA RDMA 功能導入 vSphere,可以讓深度學習訓練橫向擴充至具有接近裸機之效能的多個節點,甚至可以達到最大的深度學習訓練工作負載。

RDMA 技術搭載了 NVIDIA ConnectX SmartNIC 和 BlueField DPU,可以改善在網路介面卡(network interface card,NIC)與 GPU 記憶體之間直接移動資料時的頻寬和延遲。

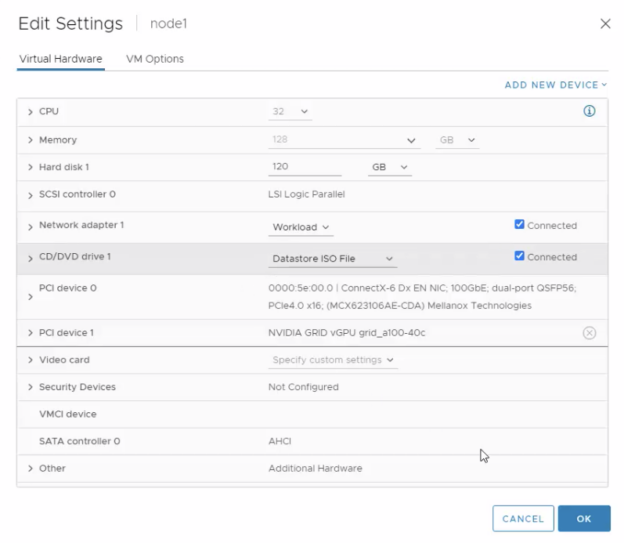

IT 管理員可以使用熟悉的工具(例如 VMware vCenter),將多個節點布建為 VM。 這些 VM 可以配置為將 NVIDIA 網路和 vGPU 資源用於 RDMA。

VMware 與 RDMA over Converged Ethernet (RoCE) 整合,打造出比之前更快的 AI 和機器學習功能。搭載 NVIDIA AI Enterprise 軟體的 vSphere 7 Update 2,是在 Intel CPU 上支援具有 ATS 功能的 RDMA,以進一步最佳化 NIC 與 GPU 之間的 GPUDirect 頻寬,使傳輸量不受 PCIe 匯流排的速度限制。 因此,資料科學家可以針對新資料進行迭代,並在一天內重新訓練更多次,以大幅提高生產力。

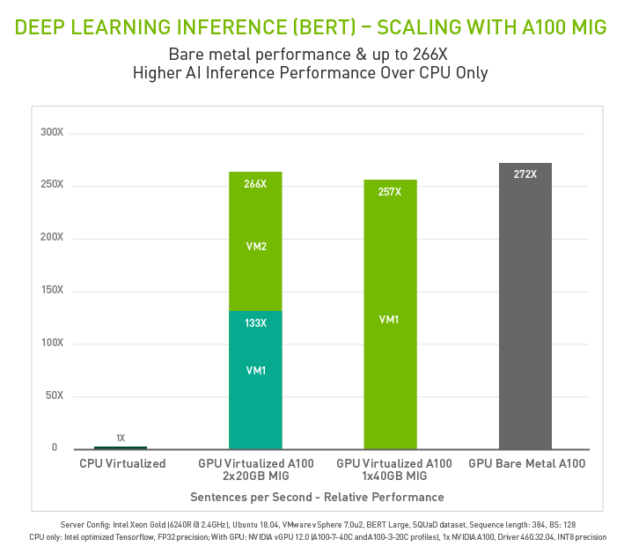

現在,看一看進一步為深度學習推論工作負載賦能的 VMware 新功能。vSphere 7 Update 2 可以支援最新的 GPU Ampere 架構,例如 NVIDIA A100 GPU。 此 GPU 可以配置為使用多執行個體 GPU (MIG)。 此類型的 GPU 分割,特別有益於無法完全飽和 GPU 運算能力的推論工作負載,以及需要低延遲回應和錯誤隔離的使用案例。 下方圖表是說明使用啟用 MIG 的虛擬化 GPU、虛擬化 CPU,以及裸機執行自然語言推論的效能。

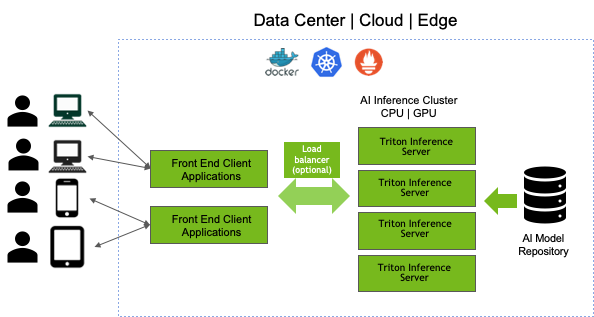

讓我們看一看使用具備 MIG 模式的單一 NVIDIA A100 搭配 VMware vSphere,執行多個推論工作負載的使用案例。 NVIDIA Triton Inference Server 是包含在 NVIDIA AI Enterprise 套件中的 AI 應用程式框架。 它是以 Docker 容器的形式提供,並與 Kubernetes 整合,以進行協調和自動擴縮。此解決方案可以協助前端用戶端應用程式提交來自 AI 推論叢集的推論要求,並可在 AI 模型儲存庫中為模型服務。

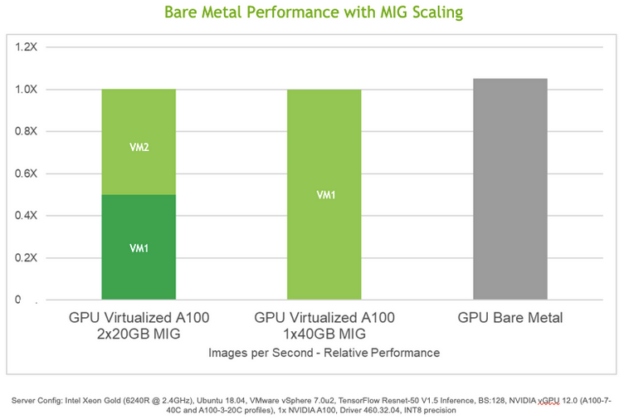

讓我們進一步研究此使用案例,例如多個終端使用者或部門提交推論要求,以針對衛星影像執行物件偵測。 在 AI 模型儲存庫中,有經過預先訓練的物件偵測模型,可以偵測衛星影像中的多個物件,例如建築物、樹木、消防栓或井場地面設施。 單一 NVIDIA A100 GPU可以利用 MIG 空間分割,服務多個推論要求,進而最佳化企業中寶貴與強大的 GPU 資源利用率。下方圖表說明了使用啟用 MIG 的虛擬化 GPU、虛擬化 CPU,以及裸機執行 ResNet-50 物件偵測推論的效能。

NVIDIA A100 – 40GB GPU 可以使用 Triton Inference Server,加上 vSphere 7.0 U2 中增加的 MIG 支援,分成多達 7 個 GPU 切片,且每一個切片或執行個體皆各別具有平行執行的專用運算資源,並可預測傳輸量和延遲。IT 管理員是使用 vCenter,為 VM 分配單一 MIG 分割區。 若需要詳細資訊,請參閱 VMware 的技術部落格文章「Multiple Machine Learning Workloads Using GPUs:New Features in vSphere 7 Update 2」。

當企業朝向 AI 和雲端運算邁進時,需要新的資料中心架構,以便能同時支援現有的和現代技術。您可以將加速伺服器加入核心企業資料中心,並使用 VMware vCenter 等標準工具進行管理。VMware與 NVIDIA 密切合作,為 vSphere 7.0 U2 導入新功能,以利用企業中的 vGPU,提供支援最高品質的低延遲回應機器學習和 AI 應用程式。