2010 年時還是一名大學生的 Ian Burkhart,與友人們一同在北卡羅萊納州外海的大西洋潛水,意外遭受了嚴重的脊髓損傷,他的胸部以下從此癱瘓。

不過現在他藉由一套搭配神經網路的人腦-電腦介面,可以用右手拿起物體、傾倒液體和玩《吉他英雄》(Guitar Hero)這套遊戲。

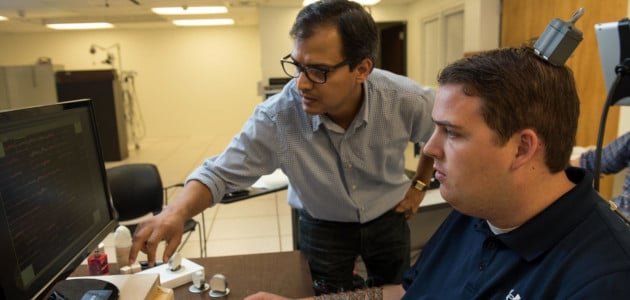

Ian Burkhart 在俄亥俄州立大學威克什納醫療中心(Wexner Medical Center)玩吉他電玩,研究員 Nick Annetta 在一旁觀看。照片由 Battelle 提供

Burkhart 是俄亥俄州立大學與附近獨立研發單位 Battelle 所率領之一項臨床試驗活動的首名參與者。

植入 Burkhart 大腦的 Blackrock Microsystems 微型晶片,連接到運行 Battelle 所開發之演算法的電腦。這項演算法解讀他的神經活動,並且將訊號傳到他右手上的電極套管。同為 Battelle 開發出的這個套管會刺激手臂的神經和肌肉,引發特定的手部動作。

Burkhart 現在只能在位於俄亥俄州立大學的實驗室裡,使用名為 NeuroLife 的系統,然而最終目標是讓 NeuroLife 系統更便於攜帶,以便裝在使用者的椅子上,使得他們能在家中使用。

如果人們可以在家裡使用 NeuroLife 系統執行吃飯、刷牙和穿衣等日常活動,便「會對他們獨立生活的能力產生重大影響」,Battelle 的資深研究統計學家,也是報告的共同作者 David Friedenberg 這麼說。他們的最新報告刊登在《Nature Medicine》雜誌上。

「我們希望讓使用者和照顧他們的人能輕鬆設定系統,不用一大堆博士和工程師在房間裡弄這些。」

神經網路讀取神經訊號

人工智慧這項技術已用於多種輔助技術工具上,從義肢手到更好的助聽器。深度學習模型可以為語言障礙者供提供合成語音,協助視障者看到,還有把手語翻譯成文字。

輔助裝置開發人員改採深度學習的原因之一,在於深度學習這項技術能有效對腦電活動這類充滿雜訊的訊號進行解碼。

開發單位使用與 Burkhart 進行腳本連線時取得的腦部訊號,訓練這款搭載 NVIDIA Quadro GPU 的深度學習神經解碼器,解碼器裡的演算法將神經活動變成特定的指令訊號。在與 Burkhart 進行連線時,要求他去思考執行特定的手部運動,神經網路再從中學習哪些腦部訊號對應於哪些特定動作。

在建立完整的神經解碼系統之際,最大的難題在於大腦訊號每天都在變化。「你某一天覺得很累,或是心煩意亂,可能就會影響到控制不同動作的神經活動模式。」Battelle 先進分析小組首席研究統計學家 Michael Schwemmer 說。

Burkhart 必須在腦中思考用特定方式來移動手部,才能重新校準神經網路。在 2018 年 9 月的這張照片裡,他正在俄亥俄州立大學威克什納醫療中心做著這件事。照片由 Battelle 提供。

Burkhart 一週兩次來到實驗室,每次連線時一開始都要對神經解碼器花上 15 到 30 分鐘重新進行校準,此時他是使用腳本連線的方式,去想他要移動手的哪個部分。

一週進行兩次的連線產生出新的腦部資料,用以更新兩個神經網路,其中一個使用有標記的資料進行監督式學習,另一個則是將資料用於非監督式學習活動上。

這兩套神經網路在解碼 Burkhart 的大腦訊號,以及預測他想要執行的動作方面,正確率達到 90% 以上。非監督式學習模型一年多以來都維持著如此優秀的正確率,且無需明確進行重新校準。

NeuroLife 系統加上深度學習,也加快處理使用者大腦訊號和將訊號送到電極套管所需的時間。目前的回應時滯為 0.8 秒,較舊法的時間快了 11%。

「如果想拿起一杯水,你想要在腦中想到這件事,手就會開始移動,不會想要停滯太久。我們在這方面有很仔細進行測量。」Friedenberg 說。

* 以上的精選照片顯示了 Ian Burkhart 與專案主要研究人員之一 Gaurav Sharma 在進行對話的畫面。攝影者為俄亥俄州立大學的 Jo McCulty,照片由 Battelle 提供。