在測量效能時評測基準是一項重要的工具,不過在一個快速變動的領域裡,很難追得上尖端技術的發展。日前 Intel 對於他們應允許久的 Xeon Phi 處理器公布了一些錯誤的「事實」。

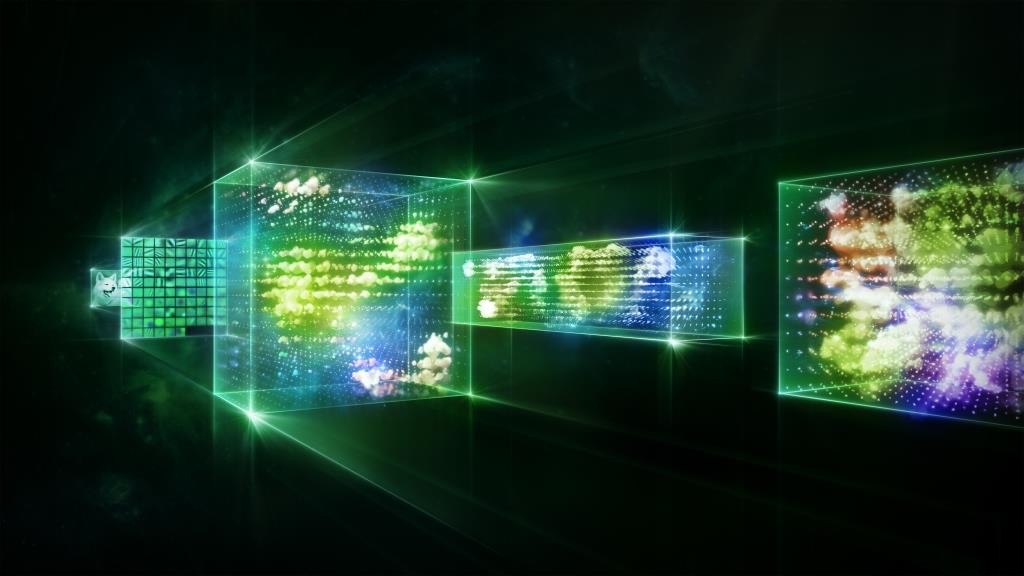

如今部分領域的變動速度比深度學習還要更快,現在神經網路的深度比一年前就要加深了六倍,而且還能強大。在多 GPU 可擴展性方面出現新的技術,提供更快速的訓練表現。

從 Kepler 更換到 Maxwell,再到當前最新的 Pascal 架構系統,像是擁有八個 Tesla P100 GPU 的 DGX-1 ,我們的架構與軟體在一年內將訓練神經網路的時間加快了10倍。

因此剛進入這個領域的人不清楚軟硬體兩方面的各種發展,是可以理解的。

舉例來說,Intel 日前公布一些過時的基準,對使用 Knights Landing Xeon Phi 處理器進行深度學習的表現提出三項主張:

- Xeon Phi 在訓練方面的速度是 GPU 的 2.3 倍(1)

- Xeon Phi 在結點的可擴展表現方面,優秀程度較 GPU 高出 38%(2)

- Xeon Phi 提供達128個節點的可擴展能力,GPU 卻無法做到這一點(3)

我們在此要對這三點進行說明,並且更正可能對讀者造成的誤解。

Caffe新舊之別

Intel 使用18個月前的 Caffe AlexNet 資料,將使用四個 Maxwell GPUs 的系統與四個 Xeon Phi 伺服器進行比較。根據在此可公開取得的最新版本 Caffe AlexNet 資料,Intel 就會發現使用四個Maxwell GPUs 的同一套系統,在訓練時間方面較四個 Xeon Phi 伺服器快上 30%。

其實搭載四個 Pascal 架構 NVIDIA TITAN X GPUs 的系統,在訓練速度方面快上 90%,而一個 NVIDIA DGX-1 更是比四個 Xeon Phi 伺服器的訓練時間快上5倍。

可擴展能力的優秀程度高出 38%

Intel 將在32個 Xeon Phi 伺服器上訓練 Caffe GoogleNet 的效能,與在橡樹嶺國家實驗室 Titan 超級電腦的32個伺服器上進行訓練的結果加以比較。Titan超級電腦使用四年前的 GPU(Tesla K20X)與承襲自更早以前 Jaguar 超級電腦的互連技術。Xeon Phi 的測試結果則是採用最新的互連技術。

使用較新的 Maxwell 架構 GPU 與互連技術,百度表示他們的語音訓練工作量可以線性放大到最多128個 GPU。

所謂的可擴展性取決於程式碼與基本處理器之間的互連技術和架構優化。GPU 為百度這樣子的客戶提供了優秀的可擴展能力。

強大的可擴展能力可到128個節點

Intel 主張128個 Xeon Phi 伺服器的效能較單個 Xeon Phi 伺服器高出50倍,GPU 卻無此相關可擴展數據。如前所述,百度已經公布結果,顯示以近乎線性的方式可放大到128個 GPU。

在強大的可擴展能力方面,我們認為強節點比弱節點更優秀。一個擁有多個強大 GPU 的強伺服器能較多個弱節點提供出色的性能表現,而每個弱節點擁有一或兩個像是 Xeon Phi 一般能力不佳的處理器。舉例來說,單個 DGX-1 系統的強大擴展能力便較至少21個 Xeon Phi 伺服器要更為卓越(DGX-1 的速度是4個 Xeon Phi 伺服器的 5.3 倍)。

人工智慧的時代

深度學習有可能改寫運算技術、改善我們的生活、提升商業系統的效率和智慧,以深遠的方式協助人類在諸多方面有所進展。那正是我們多年來不斷增進設計平行處理器的能力,創造出能加速推動深度學習的軟體和技術之故。

我們對深度學習投入既深且廣的心力,每個架構皆獲得 NVIDIA 最大的支援,且每個重量級的深度學習研究員、實驗室及企業也都使用 NVIDIA 的 GPU。

我們雖能更正對方提出的每一項錯誤主張,卻覺得使用舊的 Kepler GPUs 和過時的軟體來深度學習測試活動,是一項可以輕鬆修正的錯誤,如此才能讓產業與時俱進。

很高興 Intel 如今也致力於深度學習領域,這是人工智慧時代裡最重要的一項運算革命,且深度學習的浪潮已經大到不可忽視,不過他們還是應該認清楚事實。