原本的自動電話語音和已經發展數十年的 GPS 導航系統都只能發出生硬的機器合成聲音,而人工智慧 (AI) 卻讓智慧型手機和智慧音箱中的虛擬助理呈現逼真的語調。不過,AI 合成的聲音和我們在日常對話及媒體中聽到的真實人聲之間,還是差了那麼一點,原因在於人們說話時帶有複雜的節奏、音調和音色,這是很難以 AI 仿真出來的。

然而這個差距正在迅速縮小。NVIDIA 的研究人員正在打造高品質、可控制的語音合成模型與工具,它們能捕捉人類口說聲音中的豐富細節,又不會聽起來人工感很重。研究人員將於 INTERSPEECH 2021 大會展示這項最新的研究成果,這場會議將持續舉辦至 9 月 3 日。

這些模型有助銀行和零售商的自動語音客服,也能讓電玩遊戲或書籍中的人物更為生動,並即時為數位分身加上合成語音。NVIDIA 內部的創意團隊甚至運用這項技術,為一支介紹 AI 的系列影片製作出富有表現力的旁白內容。

表達性語言合成只是 NVIDIA Research 團隊在對話式 AI 的其中一項研究,這個領域還包括自然語言處理、自動語音辨識、關鍵字偵測、音訊增強等。這項先進研究成果的部分內容已透過 NVIDIA NeMo 工具套件成為開放原始碼,可以在 NGC 容器及其它軟體中心取得,並經最佳化調整,能在 NVIDIA GPU 上高效執行。

《I AM AI》的幕後花絮

NVIDIA 的研究人員與創意專家對於對話式 AI 不是只會坐而言,還會起而行,在《I AM AI》系列影片中實際運用突破性的語音合成模型,介紹重塑各產業發展的全球 AI 創新者。

但直到最近,都是由真人擔任這些影片的旁白。過去的語音合成模型對於合成聲音的節奏和音調控制能力有限,因此和真人旁白的影片相比,嘗試以 AI 製作影片旁白無法激起觀眾的情感。

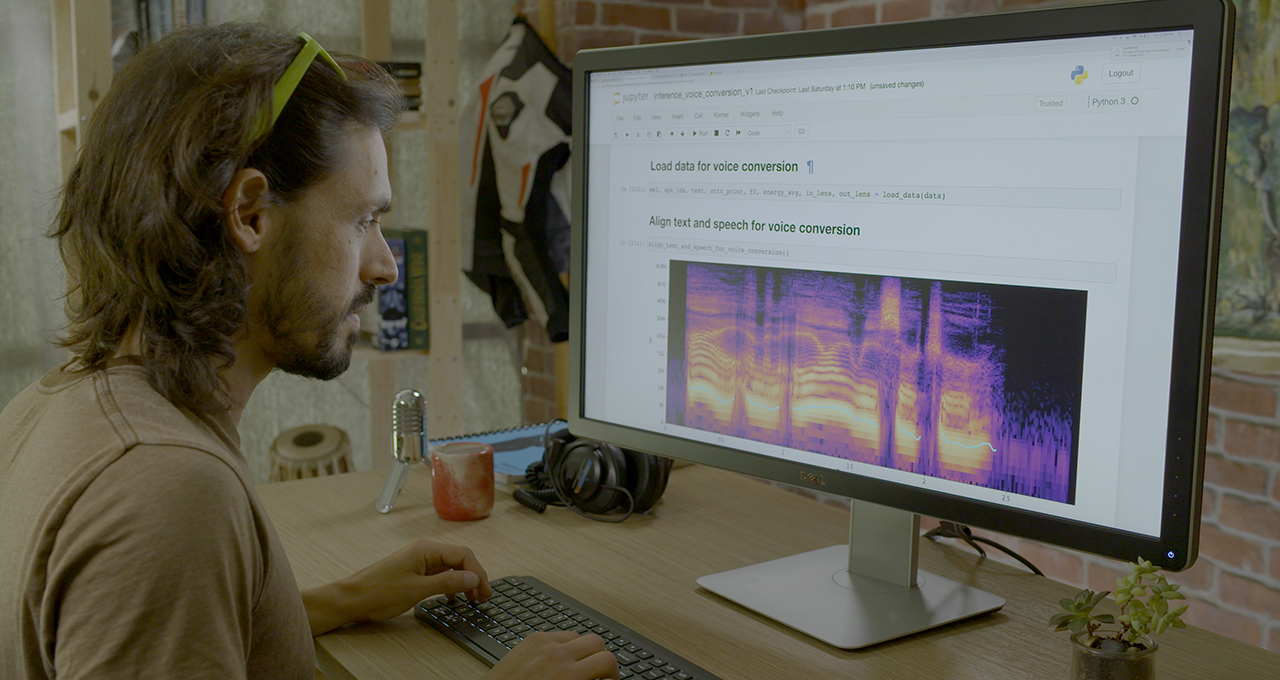

在過去的一年裡情況出現了變化,NVIDIA 的文字轉語音 (TTS) 研究團隊發展出更強大、控制能力更強的語音合成模型,就像是我們在 SIGGRAPH Real-Time Live 競賽獲獎的展示內容所使用的 RAD-TTS 模型。透過 RAD-TTS,使用個人說話的聲音來訓練文字轉語音模型,可以將任何文字提示變成說話者的聲音。

聲音轉換是它的另一項功能,例如畫面上是 A 在說話 (甚至是唱歌),觀眾們聽到的卻是 B 的聲音。設計 RAD-TTS 介面的靈感來源是將人的聲音當成一種樂器,使用者便能夠逐幀微調合成聲音的音調、持續時間和能量。

影片製作人可以使用這個介面,錄製自己讀出影片腳本的聲音,接著用 AI 模型將說話內容變成女性旁白者的聲音。製作人可以再運用這個基本的旁白內容,像配音員一樣指導 AI 並進行調整,讓合成出來的語音強調特定字眼、修改旁白節奏,以更貼切地表達影片的調性。

這個 AI 模型不只能用在配音上:文字轉語音的功能還能用在遊戲、協助聲音機能或語言機能障礙者,或幫助使用者用自己的聲音翻譯不同語言;甚至還能重現著名歌手的表演,不僅可以配合歌曲旋律,還能配合人聲背後所表達的情感。

讓 AI 開發人員、研究人員取得語音技術

研究人員、開發人員和創作者有了 NVIDIA NeMo 這個用於 GPU 加速的對話式 AI 開源碼 Python 工具包,便能為自己的應用試驗及微調語音模型取得先機。

使用 NeMo 中易用的 API 和已經訓練好的模型,可以協助研究人員開發和自訂用於文字轉語音、自然語言處理及即時自動語音辨識的模型。許多模型已經在 NVIDIA DGX 系統上使用超過十萬小時的開源資料集完成訓練,開發人員可以按照自己的應用場景,在 NVIDIA Tensor 核心 GPU 上以混合精度運算微調任何模型。

NVIDIA NeMo 還藉由 NGC 提供在 Mozilla Common Voice 進行訓練的模型,在 Mozilla Common Voice 資料集中擁有 76 種語言、近 1.4 萬小時的群眾外包語音資料。這項由 NVIDIA 支持的專案企圖以全球最大規模的開放數據語音資料集,讓更多人接觸到語音技術。

語音寶盒:NVIDIA 研究人員揭曉 AI 語音技術

INTERSPEECH 大會聚集超過一千名研究人員,展現他們在語音技術的突破性成果。NVIDIA Research 團隊將在本週舉行的 INTERSPEECH 大會上,對開發人員展示對話式 AI 模型架構與完全格式化的語音資料集。

敬請關注以下由 NVIDIA 講者帶領進行的會議活動:

- 8 月 31 日 (週二):Scene-Agnostic Multi-Microphone Speech Dereverberation

- 9 月 1 日 (週三):SPGISpeech: 5,000 Hours of Transcribed Financial Audio for Fully Formatted End-to-End Speech Recognition

- 9 月 1 日 (週三):Hi-Fi Multi-Speaker English TTS Dataset

- 9 月 2 日 (週四):TalkNet 2: Non-Autoregressive Depth-Wise Separable Convolutional Model for Speech Synthesis with Explicit Pitch and Duration Prediction

- 9 月 3 日 (週五):Compressing 1D Time-Channel Separable Convolutions Using Sparse Random Ternary Matrices

- 9 月 3 日 (週五):NeMo Inverse Text Normalization: From Development to Production

在 NGC 目錄中搜尋 NVIDIA NeMo 模型,並收聽 NVIDIA 研究人員在 INTERSPEECH 大會的精彩演講。