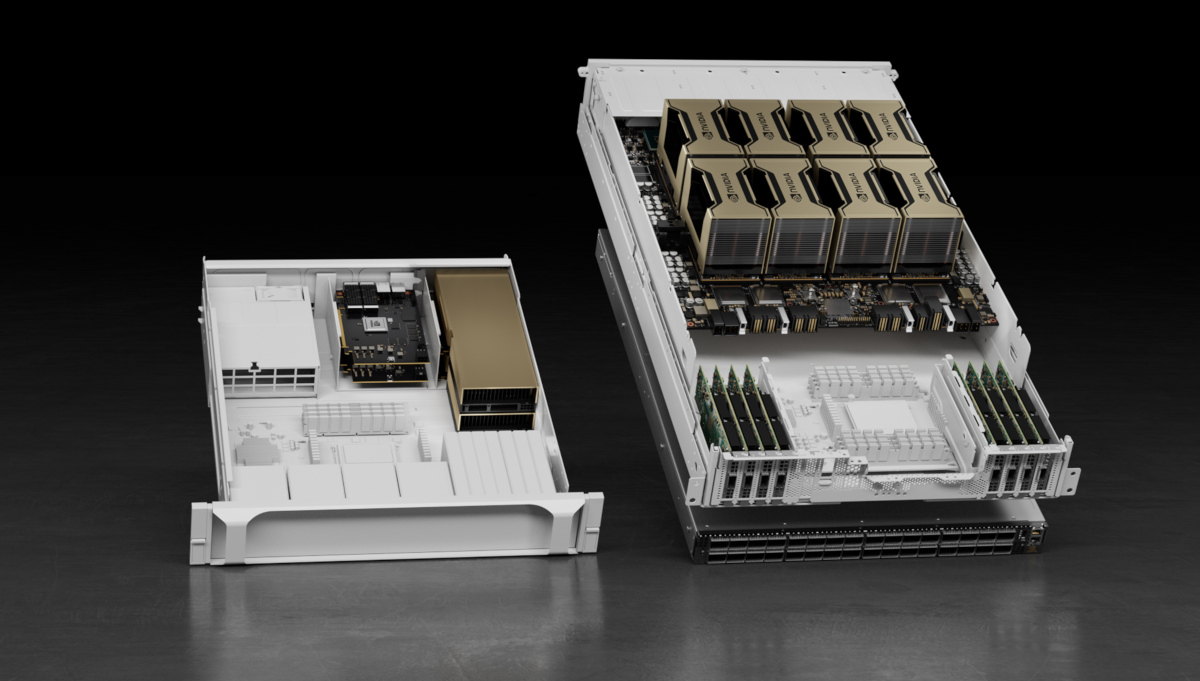

NVIDIA (輝達) 今日宣佈 NVIDIA HGX™ 人工智慧超級運算平台將加入融合人工智慧 (AI) 與高效能運算 (HPC) 的新技術,具備更強大的能力,讓更多產業能運用超級運算技術。為了加速開拓工業 AI 與 HPC 的新時代,NVIDIA 在 HGX 平台上加入三項關鍵技術,分別是 NVIDIA® A100 80GB PCIe GPU、NVIDIA NDR 400G InfiniBand 網路與 NVIDIA Magnum IO™ GPUDirect™ Storage 軟體,將共同提供極致效能,以促進工業 HPC 領域的創新。

源訊科技 (Atos)、戴爾科技集團 (Dell Technologies)、慧與科技 (Hewlett Packard Enterprise;HPE)、聯想 (Lenovo)、Microsoft Azure 與 NetApp 等數十個合作夥伴,皆使用 NVIDIA HGX 平台來發展下一代系統及解決方案。

NVIDIA 創辦人暨執行長黃仁勳表示:「從學術界掀起的 HPC 革命迅速擴大到各行各業。關鍵動力推動以超指數、超摩爾定律的方式向前邁進,讓各行各業都能使用到 HPC 這項利器。NVIDIA 的 HGX 平台提供研究人員無與倫比的高效能運算加速技術,以解決產業所面臨最為棘手的問題。」

業界領導者使用 HGX 平台推動創新突破

高科技工業先驅通用電氣 (General Electric) 正使用 HGX 平台,將 HPC 創新應用於引領燃氣渦輪機和噴射發動機設計創新的計算流體力學 (CFD) 模擬。HGX 平台實現了指數級加速通用電氣的 GENESIS 代碼中的突破性 CFD 方法,它採用大渦流模擬來研究渦輪機內部亂流的影響,渦輪機內部是由數百個葉片所組成,且涉及獨特且複雜的幾何學。

除了推動工業 HPC 轉型,HGX 平台也在加速世界各地的科學型 HPC 系統,包括位於愛丁堡大學的下一代超級電腦,此消息也在今天公布。

NVIDIA A100 80GB PCIe 為 AI 與 HPC 提高運作效能

NVIDIA A100 Tensor Core GPU 提供前所未有的 HPC 加速技術,以解決與工業 HPC 習習相關的 AI、資料分析、模型訓練與模擬的複雜挑戰。與 A100 40GB 相比,A100 80GB PCIe GPU 提高 25% 的 GPU 記憶體頻寬,達到每秒 2TB,並且提供 80GB 的 HBM2e 高頻寬記憶體。

A100 80GB PCIe 的龐大記憶體容量與高記憶體頻寬,可以在記憶體中保存更多資料和更大的神經網路,將節點間的通訊和能耗量降至最低。更高速的記憶體頻寬讓研究人員能夠加快處理速度、更快獲得結果,徹底發揮 IT 投資的價值。

A100 80GB PCIe 採用具備 NVIDIA 多執行個體 (MIG) 技術的 NVIDIA Ampere 架構,可以加速處理 AI 推論等小型作業負載。MIG 能讓 HPC 系統在保證服務品質的情況下,縮小運算和記憶體規模。除了 PCIe 外,另有搭載四個或八個 NVIDIA HGX A100 的配置。

支援 A100 80GB PCIe 的 NVIDIA 合作夥伴包括 Atos、思科 (Cisco)、戴爾科技集團 (Dell Technologies)、富士通 (Fujitsu)、技嘉科技 (GIGABYTE)、新華三 (New H3C Information Technologies)、HPE (慧與)、浪潮 (Inspur Electronic Information)、聯想 (Lenovo)、Penguin Computing、雲達科技 (QCT) 與美超微 (Supermicro)。搭載 A100 GPU 並透過 NVLink 互連的 HGX 平台亦可在 Amazon Web Services、Google Cloud、Microsoft Azure 及 Oracle Cloud Infrastructure 等雲端服務中取得。

下一代 NDR 400Gb/s InfiniBand 交換器系統

NVIDIA InfiniBand 是全球唯一可完全卸載的網路內運算互連技術,可為需要優異資料處理能力的 HPC 系統提供超強大的效益。NDR InfiniBand 技術可因應工業與科學 HPC 系統面臨的艱鉅挑戰而隨之調整效能規模。NVIDIA Quantum™-2 固定配置交換器系統擁有 64 個 NDR 400Gb/s InfiniBand 連接埠 (或是 128 個 NDR200 連接埠),與 HDR InfiniBand 相比,連接埠的密度高出三倍。

NVIDIA Quantum™-2 模組化交換器提供具擴充能力的連接埠配置,最多提供 2,048 個 NDR 400Gb/s InfiniBand 連接埠 (或4,096個 NDR200 連接埠),雙向總處理量為每秒 1.64 petabits,是上一代的五倍。擁有 2,048 個連接埠的交換器,擴充能力較上一代產品高出 6.5 倍,透過 DragonFly+ 網路拓撲結構,只要三個交換器 hop 就能連接超過 100 萬個節點。第三代 NVIDIA SHARP In-Network Computing 資料縮減技術與上一代相比,能提高 32 倍 AI 加速能力,提升高效能工業和科學應用程式的效能。

先進的管理功能包括自我修復網路功能,以及 NVIDIA In-Network Computing 加速引擎。NVIDIA UFM® Cyber-AI 平台進一步將資料中心的停機時間降至最低。

按照產業標準,預計將於年底前供樣的 NVIDIA Quantum-2 交換可以向前與向後相容,讓用戶能輕鬆遷移與擴展現有系統及軟體。

包括 Atos、DataDirect Networks (DDN)、Dell Technologies、Excelero、技嘉 (GIGABYTE)、 HPE、Lenovo、Penguin、QCT、Supermicro、VAST 與 WekaIO 在內等頂尖基礎設備製造商,預計在其企業級與 HPC 產品中加入 Quantum-2 NDR 400Gb/s InfiniBand 交換器。Azure 等雲端服務供應商也將運用 InfiniBand 技術的優勢。

推出 Magnum IO GPUDirect Storage 軟體

Magnum IO GPUDirect Storage 軟體可以在 GPU 記憶體與儲存裝置之間直接存取記憶體,以絕佳效能來處理複雜的作業負載。直接存取記憶體路徑的較低 I/O 延遲嘉惠了應用程式,還能使用網路介面的全部頻寬、減少 CPU 的利用負載與處理資料消耗量增加所帶來的影響。

Magnum IO GPUDirect Storage 軟體已經上市,支援此軟體的領導業者包括 DDN、Dell Technologies、Excelero、IBM Storage、美光 (Micron)、NetApp、Pavilion、ScaleFlux、VAST 與 WekaIO。在 https://developer.nvidia.com/gpudirect-storage 網頁中可取得儲存裝置合作夥伴的完整名單。