Amazon Web Services (AWS) 的首個 GPU 執行個體於十年前亮相,搭載的是 NVIDIA M2050。當時以 CUDA 為基礎的應用程式主要集中在加速科學模擬,而人工智慧 (AI) 和深度學習的興起還遙遙無期。

此後 AWS 又陸續加入穩定的雲端 GPU 執行個體,包括 K80 (p2)、K520 (g3)、M60 (g4)、V100 (p3/ p3dn) 和 T4 (g4)。

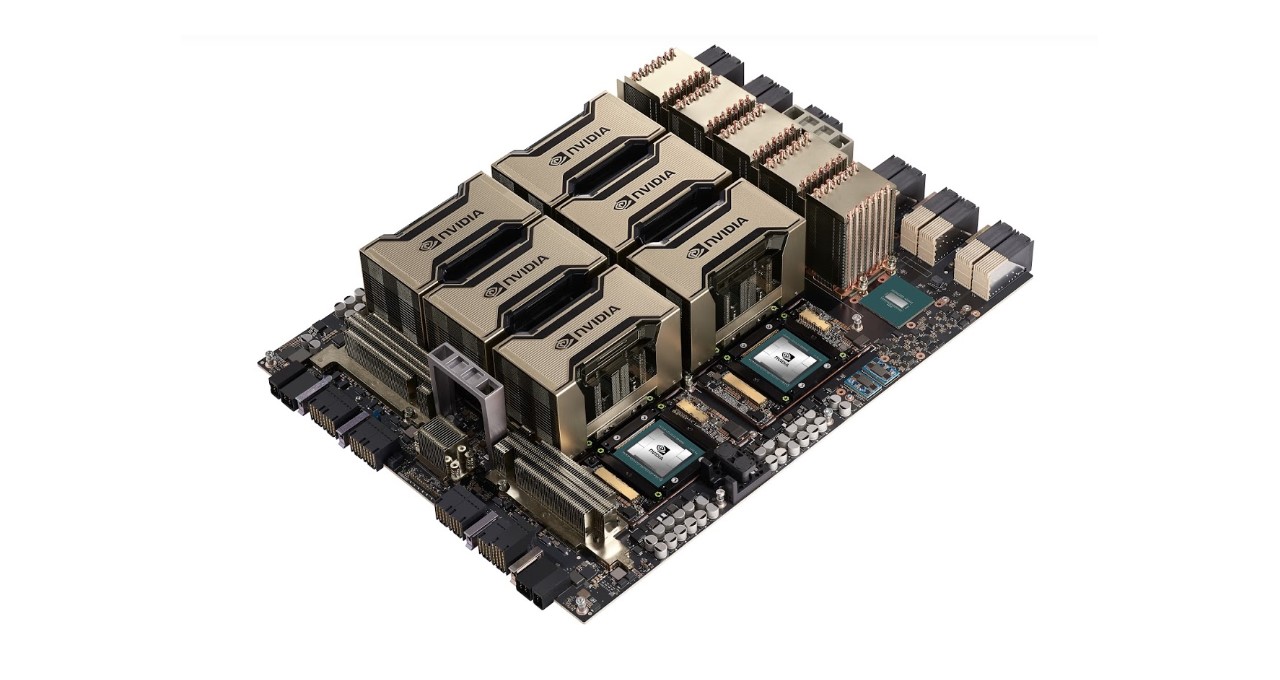

隨著全新 P4d 執行個體 ,AWS 將在最新 NVIDIA A100 Tensor Core GPU 的支援下,為加速運算領域的下一個十年打穩基礎。

全新 P4d 執行個體為機器學習訓練與高效能運算應用程式,提供 AWS 上採用 GPU 之最高效能、最具成本效益的平台。與預設的 FP32 精準度相比,使用 FP16 的執行個體訓練機器學習模型的時間縮短了三倍,使用 TF32 進行訓練的時間縮短了六倍。

這些執行個體亦提供了極為卓越的推論表現。上個月,NVIDIA A100 GPU 於 MLPerf Inference 基準測試項目中所向披靡,其效能較 CPU 快上 237 倍。

此外,許多 AWS 服務都支援 P4d 執行個體,包括 Amazon Elastic Container Services、Amazon Elastic Kubernetes Service、AWS ParallelCluster 及 Amazon SageMaker。P4d 還能使用 NGC 所提供的各種經過優化的容器化軟體,包括高效能運算應用程式、AI 框架、預先訓練模型、Helm chart,以及 TensorRT 和 Triton 推論伺服器等推論軟體。

現在可於美國東部和西部地區使用 P4d 執行個體,很快地將會開放給其它地區使用。用戶能夠以隨需執行個體 (On-Demand)、Savings Plans、預留執行個體 (Reserved Instance) 或 Spot 執行個體等方式來購買。

GPU 雲端運算的第一個十年,已經將超過 100 exaflops 的 AI 運算能力帶入市場。現在有了 NVIDIA A100 GPU 支持的 Amazon EC2 P4d 執行個體,將為 GPU 雲端運算領域的下一個十年開創美好的開端。

NVIDIA 與 AWS 攜手打造許多應用程式,並不斷突破 AI 的發展。我們迫不及待地想知道客戶將如何發揮這股潛力。

請至 AWS,立即開始使用 P4d 執行個體。