深度神經網路採用兩階段方法來解決光達處理挑戰。

自動駕駛實驗室

編輯手扎: 這是 NVIDIA DRIVE Labs 自動駕駛實驗室系列最新上架的影片,在 自動駕駛實驗室系列影片中,我們以工程技術為重點的角度關注實現自動駕駛汽車的各個挑戰。您可點此觀看我們所有的自動駕駛實驗室系列影片。

光達可以為自動駕駛汽車提供雷射聚焦。

為自動駕駛汽車提供豐富的視角

通過從周圍環境反射回來的雷射信號,光達感測器可以讓自動駕駛汽車建構出一個詳細準確的 3D 場景,以理解其所處的周圍環境。

然而,用於處理光達數據的傳統方法面臨重大挑戰。其中包括檢測和分類不同類型的對象,場景和天氣狀況的能力,以及性能和可靠性的限制。

在 DRIVE Labs 的這一集中,我們將介紹 LidarNet 深度神經網路,該網路使用了汽車周圍場景的多個視角或視圖,以克服傳統的光達處理方法的局限性。

AI助力的解決方案

基於 DNN 研究方法的 AI 已成為解決傳統光達感知挑戰的首選解決方案。

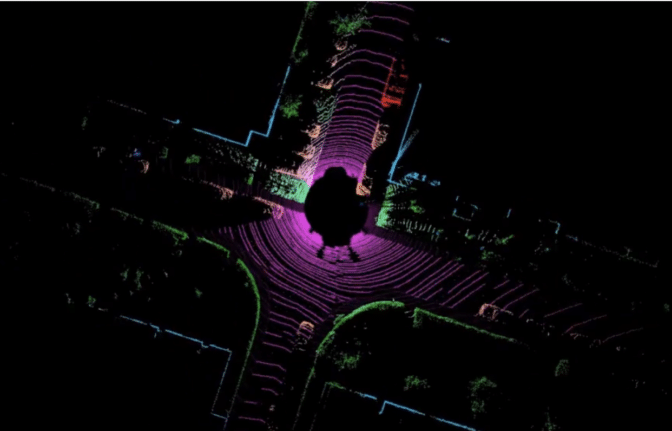

一種 AI 方法是使用光達 DNN 在光達點雲數據上執行自上至下或“鳥瞰圖 ”( BEV )對象檢測。首先在場景上方某個高度放置一個虛擬攝影機(好似頭頂飛過的鳥),然後通過同軸投影將每個數據點的 3D 坐標重新投影到該虛擬攝影機的視圖中。

鳥瞰圖 光達 DNN 在其上方使用2D 卷積來檢測動態對象,例如汽車,卡車,公共汽車,行人,騎自行車的人和其他道路使用者。 2D 卷積運行速度很快,因此非常適合在實時自動駕駛應用中使用。

但是,當檢測對象的運動彷彿自上而下時,此方法可能會遇到障礙。例如,在鳥瞰圖中,行人或自行車可能看起來像電線桿,樹幹或草叢之類的物體,從而導致感知錯誤。

另一種 AI 方法使用 3D 光達點雲數據作為 DNN 的輸入,該 DNN 在其多層中使用 3D 卷積來檢測對象。當 DNN 用 3D 形狀檢測目標對象時可以提高精度。但是,光達點雲的 3D 卷積 DNN 處理不太適用於實時自動駕駛應用。

擁有多視角的LidarNet

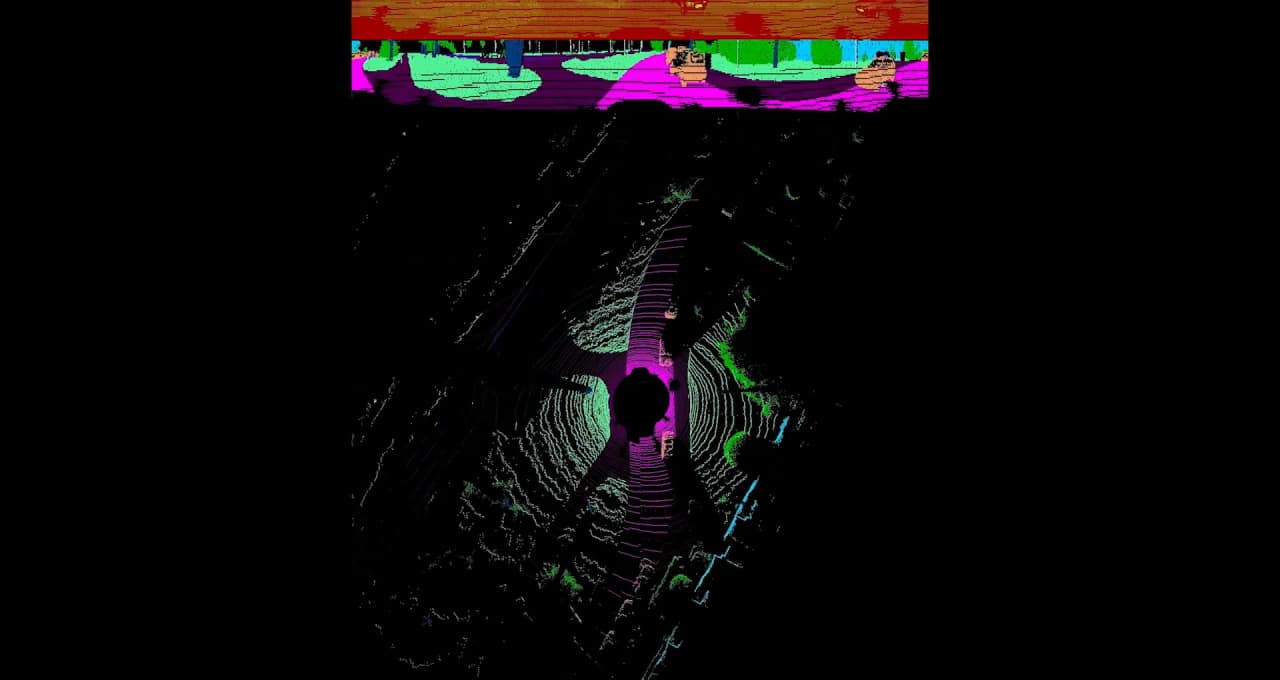

為了克服這兩種基於 AI 方法的局限性,我們開發了多角度 LidarNet 深度神經網路。該方法分為兩個階段。第一階段使用透視觀察的光達掃描數據提取相關場景的語義訊息(圖 1 )。也就是通過“展開” 360 度環繞光達掃描,讓整個全景圖展現在自動駕駛汽車面前。

第一階段語義訊息是 DNN 可以更好地透視觀察對象的形狀(例如,行走的人的形狀)。

第一階段場景分為不同類別的動態對象,例如汽車,卡車,公車,巴士,行人,騎自行車的人和摩托車騎士,以及靜態道路場景元素,例如路面,人行道,建築物,樹木和交通標誌。

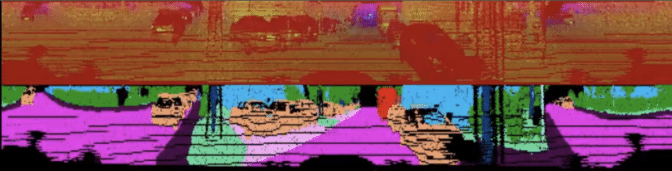

然後,將光達網路第一階段生成的語義分段轉換投射到 鳥瞰圖 中,並與從光達點雲中獲得的每個位置的高度數據進行組合。這一過程所產生的輸出將利用第二階段的輸入(圖 2 )。

第二階段的 DNN 在 鳥瞰圖貼標的數據上進行訓練,以預測第一階段標識的對象周圍自上而下的 2D 邊界框。此階段仍使用語義和高度資訊來擷取對象實例。這在鳥瞰圖中更容易實現,因為在圖中的對象不會相互遮擋。

第二階段 DNN 在帶有 BEV 標籤的數據上進行訓練,以預測第一階段標識的對象周圍的自上而下的 2D 邊界框。此階段還使用語義和高度信息來提取對象實例。由於在該視圖中對像不會相互遮擋,因此在 BEV 中更容易實現。

將這兩個階段鏈接在一起,得到一個僅處理一個光達數據的光達 DNN 。它使用端到端深度學習來輸出豐富的場景語義分割,並帶有檢測對象的 2D 邊界框。通過這種方法,該 DNN 能夠高效且完整地檢測出易受傷害的道路使用者,例如摩托車騎士,自行車騎士和行人。如此,該 DNN 能夠實現高效處理,在NVIDIA DRIVE ™ AGX平台上,每次光達掃描的推論時間僅需 7 倍。

除了多視角 LidarNet ,我們的光達處理軟體還包括一個光達目標追踪器。該追踪器是一個基於電腦視覺的後處理系統,它使用鳥瞰圖 2D 邊界框資訊和光達點幾何圖為每個目標實例計算 3D 邊界框。它還可以幫助穩定每幀 DNN 的錯誤檢測,並與低階光達處理器一起,計算汽車應避免的硬物理邊界的幾何圍欄。

AI 和傳統電腦視覺方法的結合提高了 NVIDIA 光達感知軟體的穩定性。此外,由光達感知提供的豐富感知資訊可以與攝影機和雷達檢測相結合,以建造出更強大的 L4 級到 L5 級自動駕駛系統。