人工智慧的未來發展方向為何?或許本週在加州長灘市舉行的「神經資訊處理系統大會」(Conference and Workshop on Neural Information Processing Systems,又名 NIPS),是尋找這個答案的最好去處。

我們在會場展位進行的兩項展演活動之一,便是展出由蒙特婁大學研究團隊所開發出的人工智慧系統「MILABOT」,對它提出上述問題或許能獲得有趣的答案。

這具機器人的特殊之處:與使用者進行開放式交談,話題從關於貓的雙關語到你跟母親之間的親子關係。

開發團隊一員的 Iulian Vlad Serban 在邀請其他人工智慧研究人員上台進行測試時,表示:「有些人會跟它聊上二三十分鐘,聊著自己的生活。」

在問到人工智慧的未來時,MILABOT 說出的答案,跟本週在長灘市會展中心走道上聽到七千多名學生和研究員閒聊時講出的話差不多。「我得想一下」MILABOT 說。

就跟參加全球人工智慧領域盛會之一 NIPS 的其他人一樣,NVIDIA 也在努力找出這個答案。

我們通過 NVIDIA 人工智慧實驗室支持 Serban 這些研究員,或是通過 NVAIL 計畫支援二十所頂尖大學和機構的研究計畫,工程師們提供技術協助、支援學生及使用 DGX 人工智慧超級電腦系統。

觀看與學習

其中一項答案:深度學習將協助機器與實體環境(還有實體環境裡的人類),更流暢地進行互動。

NVIDIA 執行長黃仁勳在光臨 NVIDIA 展位,停下腳步跟加州大學柏克萊分校的 Sergey Levine、Chelsea Finn 與 Frederik Ebert 談論他們的研究計畫時,表示:「我想未來幾年會出現更多自動機器,你們正站在人工智慧與機器與實體環境進行互動的十字路口。」

NVIDIA 執行長黃仁勳與 Chelsea Finn 及 Frederik Ebert 談論他們的研究成果。

柏克來大學人工智慧研究室(BAIR)的研究團隊則是在 NIPS 進行兩項演示活動,介紹深度學習的新技術如何落實上述答案。

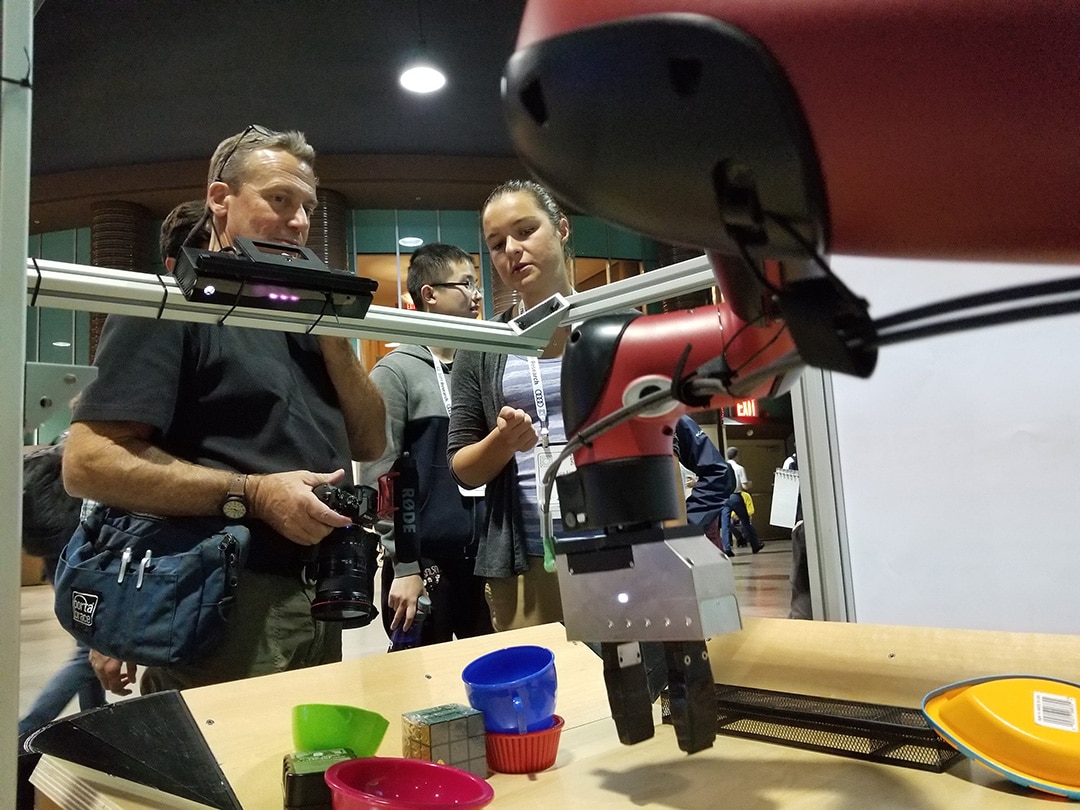

BAIR 第一項演示的是將車鑰匙或一副眼鏡等物體放在機器人的工作空間裡,接著在使用者介面上點一下,告訴機器人要移動的物體放在哪裡,還有要機器人前往的地點。

接下來機器人便會通過使用者可以看到的影片預測內容開始想像,按照機器人會採取的動作來移動你指定的物體,然後機器人使用這項預測來規畫後續動作。

拜嶄新的卷積神經網路設計,機器人的技能也讓上個月在某個單日課程裡協助訓練的學生們大吃一驚。

在第二個演示活動裡,則是引導機器人手臂進行將物體放進容器等作業。機器人會使用展示的影片找到容器,並將相同物體放進容器。

跟我們說話

MILABOT 是 NIPS 會場裡另一個吸睛焦點,許多研究人員一直想找到抓住聊天機器人出錯的方法。

是能做到沒錯,但要在哄騙機器人提出「代名詞釋疑」的研究人員不再拷問機器人的情況下,就算得運用一個效果不佳的雙關語,MILABOT 仍能繼續進行對話。

「我沒有養貓,有的話我會非常喜歡牠。」在被問及是否喜歡貓時,MILABOT 這麼回答。 (當然貓是人工智慧研究員間的一個笑話。)

蒙特婁學習演算法學院在參加 Amazon Alexa Prize 競賽時開發出這個聊天機器人,它並非靠著單一對話模型,而是22個模型。

至少在麻省理工學院的 Joseph Weizenbaum 四十年前創造了 ELIZA(對於人類提出的問題提出一知半解的反應)後,電腦科學家解決了通過言語或文字進行閒聊的這項難題。

與 ELIZA 不同的是,MILABOT 靠著創造者所描述的模型「組合體」,其中包括範本型模型、詞袋模型、序列到序列神經網絡、潛在變量神經網路模型,還有原始 ELIZA 的變體。

真正的技巧在於藉由深度強化學習來選擇要使用的模型,MILABOT 為此將強化學習(軟體代理採取一連串的學習行動,以累積最大的獎勵)用在從與人實際進行互動所收集到的資料上。

它雖不完美,卻足以吸引目光,接二連三對軟體丟出難題也讓人們哈哈大笑。

歡迎光臨

請光臨我們在 NIPS 的展位,親自觀看這些演示活動。